JuStRank: Оценка LLM-судей для ранжирования систем

С развитием генеративного искусственного интеллекта (AI) возникла необходимость в систематическом сравнении и выборе между множеством доступных моделей и конфигураций. Большие языковые модели (LLM) все чаще используются в роли судей для оценки систем, однако качество этих судей требует тщательной проверки. В данной статье мы рассмотрим концепцию JuStRank, нового бенчмарка для оценки LLM-судей, который фокусируется на их способности ранжировать системы на основе согласия с человеческими оценками.

Проблема оценки LLM-судей

Традиционно оценка LLM-судей проводилась на уровне экземпляров, где судья определяет качество отдельных ответов независимо от системы, их сгенерировавшей. Однако такой подход не учитывает системные аспекты, такие как предвзятость судьи по отношению к определенным моделям. Это может приводить к неправильным выводам о сравнительной эффективности систем.

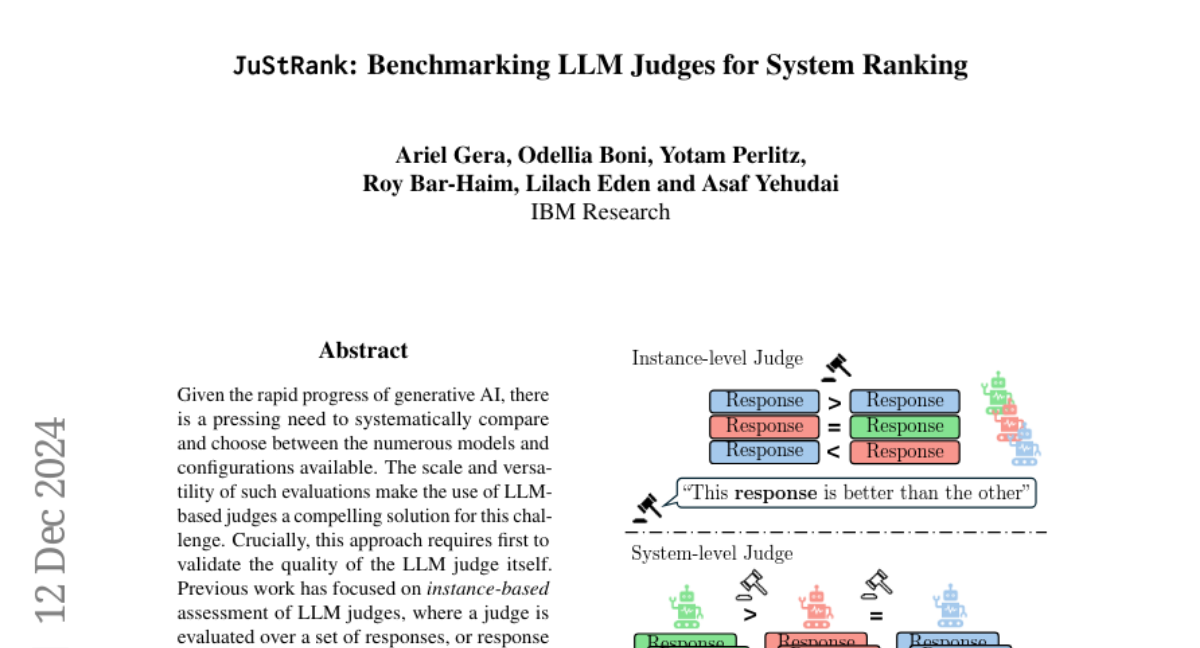

Различие между уровнями оценки

Существует два основных уровня оценки: уровень экземпляров и уровень систем. Уровень экземпляров фокусируется на том, насколько точно судья оценивает отдельные ответы, тогда как уровень систем оценивает, насколько точно судья может ранжировать различные системы. Это различие критично, поскольку даже высококачественные экземплярные судьи могут давать неверные системные ранжирования из-за предвзятости.

Концепция JuStRank

JuStRank (Judges for System Ranking) представляет собой новый бенчмарк, который позволяет оценивать LLM-судей на уровне систем. Он включает в себя 48 современных судей, как общих LLM, так и специализированных моделей вознаграждения. Основная цель JuStRank — сравнить способности судей в правильном ранжировании систем на основе их согласия с эталонным ранжированием, полученным от человека.

Оценка качества судей

Качество судей определяется через корреляцию между ранжированием, предложенным судьями, и эталонным ранжированием. JuStRank позволяет не только оценить общую производительность судей, но и провести детальный анализ их поведения, включая степень предвзятости и решительность.

Методология JuStRank

Формулировка задачи

Для оценки LLM-судей мы начинаем с набора систем и пользовательских инструкций. Каждая система генерирует ответ для каждой инструкции, и задача судей заключается в оценке качества этих ответов. Судьи получают набор оценок, который затем агрегируется для определения системного ранга.

Генерация данных

Для проведения экспериментов мы используем набор данных Arena Hard v0.1, который включает 500 сложных инструкций и ответы от 63 систем. Это обеспечивает разнообразие и сложность для оценки судей.

Оценка судей

Судьи оцениваются по нескольким критериям, включая:

- Согласие с эталонным ранжированием: Корреляция между ранжированием судьи и эталонным ранжированием.

- Предвзятость: Оценка того, насколько судья склонен оценивать определенные системы слишком высоко или низко.

- Решительность: Способность судьи делать четкие и последовательные оценки.

Результаты и анализ

Производительность судей

Результаты JuStRank показывают, что некоторые модели вознаграждения, несмотря на меньший размер, могут показывать производительность, сопоставимую с крупными LLM. Это подчеркивает важность специализированного обучения судей для достижения высоких результатов в системном ранжировании.

Влияние реализации судей

Выбор реализации судьи (например, абсолютные или сравнительные оценки) существенно влияет на качество ранжирования. В наших экспериментах реализации с абсолютными оценками, такие как числовые и Лайкерты, показали лучшие результаты по сравнению с сравнительными реализациями.

Анализ предвзятости и решительности

Мы обнаружили, что некоторые судьи демонстрируют явную предвзятость в оценках, что может искажать результаты. Например, судьи могут показывать положительную предвзятость к более сильным системам, что приводит к их завышенному ранжированию. Решительность также варьируется между судьями: некоторые из них более склонны к четким предпочтениям, чем другие.

Заключение

JuStRank представляет собой важный шаг вперед в оценке LLM-судей для системного ранжирования. Он не только позволяет более точно оценивать качество судей, но и выявляет их предвзятости и решительность, что может существенно повлиять на выбор моделей и конфигураций. С дальнейшим развитием и применением JuStRank исследователи и практики смогут более эффективно выбирать подходящих судей для своих нужд, улучшая качество оценок и выводов в области искусственного интеллекта.

Перспективы будущих исследований

Будущие исследования могут сосредоточиться на разработке специализированных судей, которые будут лучше справляться с конкретными задачами. Также важно изучить влияние различных подходов к агрегации оценок и взаимодействие между различными параметрами судей, чтобы оптимизировать процесс ранжирования. JuStRank может стать основой для дальнейших исследований в этой области, способствуя более глубокому пониманию поведения судей и их влияния на результаты оценок.