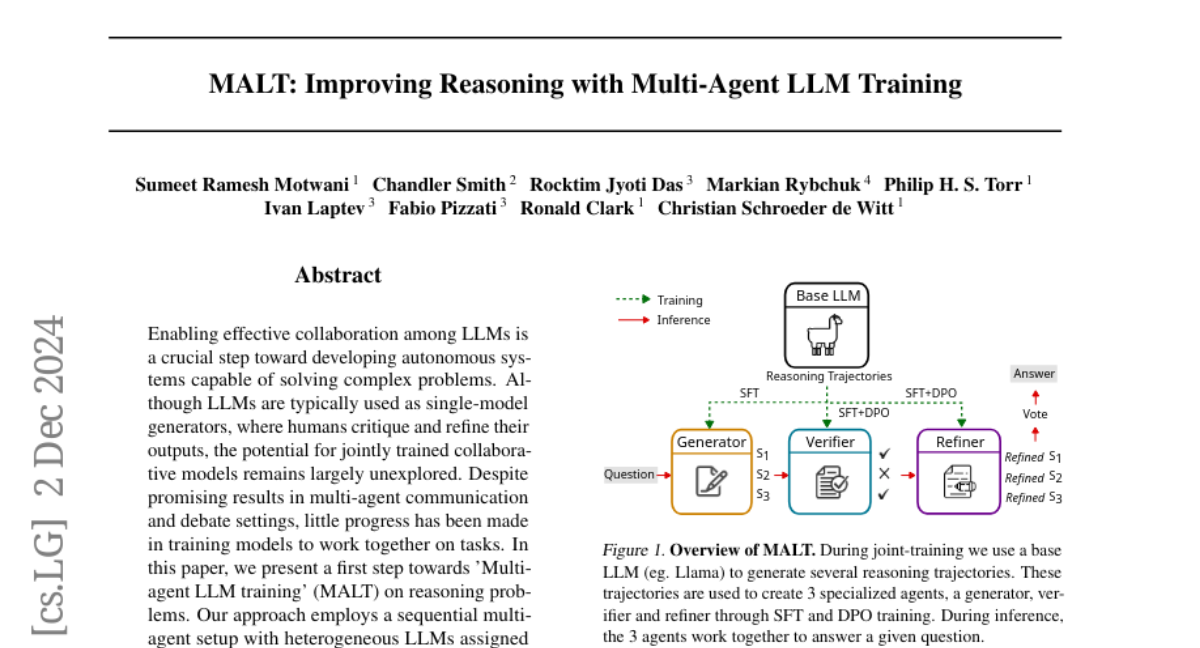

MALT: Улучшение рассуждений с помощью обучения многоагентных LLM

Включение эффективного сотрудничества между LLM является важным шагом к разработке автономных систем, способных решать сложные задачи. Хотя LLM обычно используются как генераторы с единой моделью, где люди критикуют и уточняют их результаты, потенциал совместно обученных коллаборативных моделей остается в значительной степени неизученным. Несмотря на многообещающие результаты в многоагентной коммуникации и дебатах, мало что было сделано для обучения моделей работать вместе над задачами. В этой статье мы представляем первый шаг к "Обучению многоагентных LLM" (MALT) по решению задач на рассуждения. Наш подход использует последовательную многоагентную конфигурацию с гетерогенными LLM, которым назначены специализированные роли: генератор, проверяющий и модель уточнения, которые итеративно решают задачи. Мы предлагаем процесс генерации синтетических данных на основе расширения траектории и стратегию распределения кредитов, основанную на вознаграждениях, ориентированных на общий результат. Это позволяет нашей настройке после обучения использовать как положительные, так и отрицательные траектории для автономного улучшения специализированных возможностей каждой модели в рамках совместной последовательной системы. Мы оцениваем наш подход на примерах MATH, GSM8k и CQA, где MALT на моделях Llama 3.1 8B достигает относительных улучшений в 14,14%, 7,12% и 9,40% соответственно по сравнению с той же базовой моделью. Это демонстрирует ранний прогресс в многоагентных кооперативных способностях для выполнения математических задач и вопросов общего смысла. В более общем плане, наша работа предоставляет конкретное направление для исследований в области подходов к обучению многоагентных LLM.