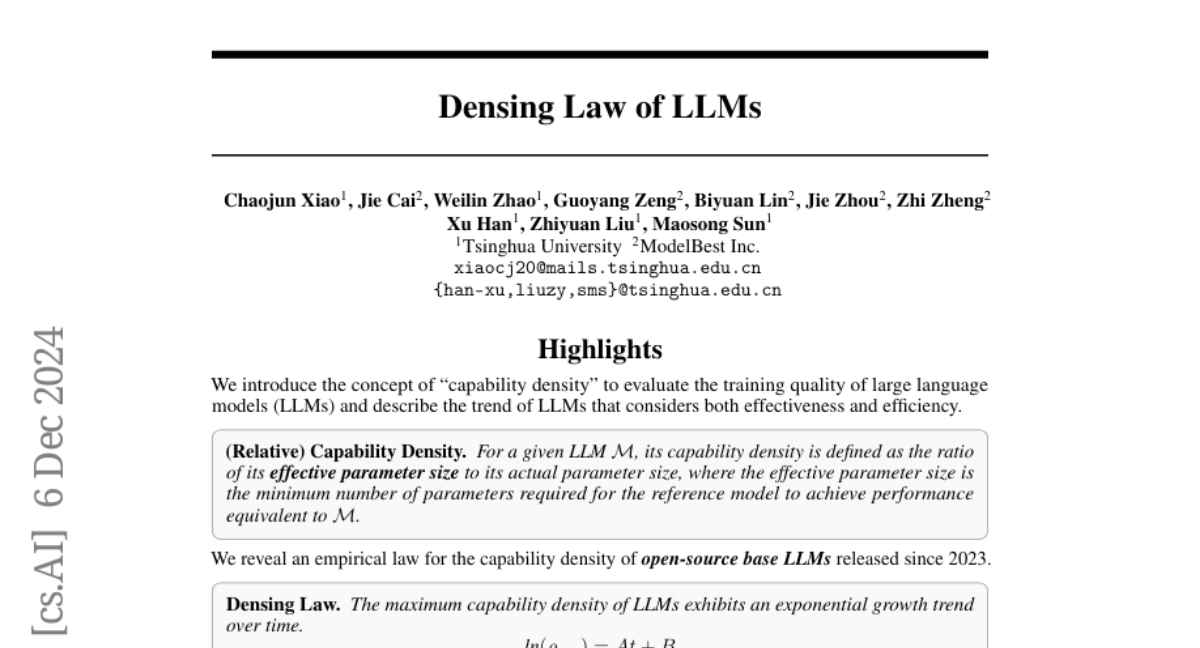

Плотность ёмкости: Новый подход к оценке больших языковых моделей

Большие языковые модели (LLM) стали важным этапом в области искусственного интеллекта, и их производительность может увеличиваться с ростом размера модели. Однако это масштабирование приносит большие проблемы для эффективности обучения и выводов, особенно для развертывания LLM в условиях ограниченных ресурсов, и тенденция к масштабированию становится все более неустойчивой. Эта статья вводит концепцию "плотности емкости" как новую метрику для оценки качества LLM на различных масштабах и описывает тенденции LLM с точки зрения как эффективности, так и результативности. Для расчета плотности емкости данной целевой LLM мы сначала вводим набор эталонных моделей и разрабатываем закон масштабирования, чтобы предсказать производительность этих эталонных моделей в зависимости от их размера параметров. Затем мы определяем эффективный размер параметров целевой LLM как размер параметров, необходимый эталонной модели для достижения эквивалентной производительности, и формализуем плотность емкости как отношение эффективного размера параметров к фактическому размеру параметров целевой LLM. Плотность емкости предоставляет унифицированную структуру для оценки как эффективности, так и результативности моделей. Наш дальнейший анализ недавно открытых базовых LLM показывает эмпирический закон (закон уплотнения), согласно которому плотность емкости LLM экспоненциально растет с течением времени. Более конкретно, используя некоторые широко используемые эталоны для оценки, плотность емкости LLM удваивается примерно каждые три месяца. Этот закон предоставляет новые перспективы для руководства будущим развитием LLM, подчеркивая важность повышения плотности емкости для достижения оптимальных результатов с минимальными вычислительными затратами.