Нормализующие потоки как мощные генеративные модели

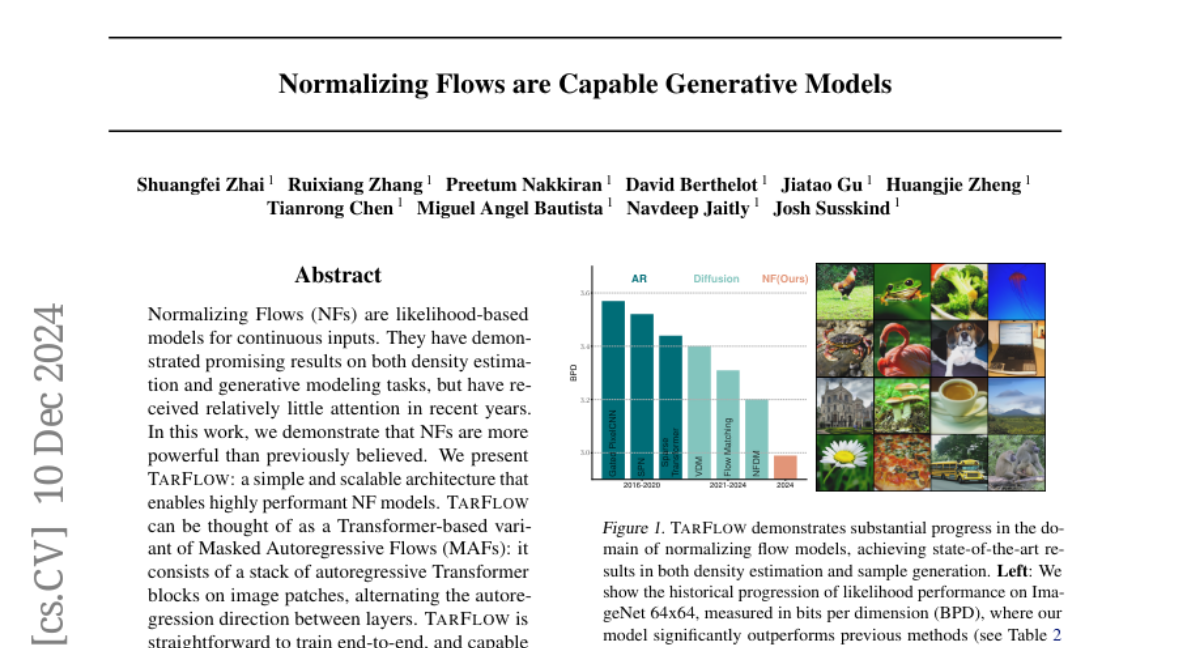

Нормализующие потоки (NFs) являются моделями, основанными на вероятности, для непрерывных входных данных. Они продемонстрировали многообещающие результаты как в оценке плотности, так и в задачах генеративного моделирования, но в последние годы получили относительно мало внимания. В этой работе мы демонстрируем, что NFs более мощные, чем считалось ранее. Мы представляем TarFlow: простую и масштабируемую архитектуру, которая позволяет создавать высокопроизводительные модели NF. TarFlow можно рассматривать как вариант автогрессивных потоков с маскированием (MAFs), основанный на Transformer: он состоит из стека автогрессивных трансформерных блоков на изображениях, чередующих направление автогрессии между слоями. TarFlow легко обучать от начала до конца и он способен напрямую моделировать и генерировать пиксели. Мы также предлагаем три ключевые техники для улучшения качества образцов: увеличение гауссовского шума во время обучения, посттренировочную процедуру денойзинга и эффективный метод управления как для условий класса, так и для безусловных настроек. Совместив это, TarFlow устанавливает новые современные результаты в оценке вероятности для изображений, опережая предыдущие лучшие методы на значительную величину, и генерирует образцы с качеством и разнообразием, сопоставимыми с диффузионными моделями, впервые с помощью самостоятельной модели NF. Мы предоставляем наш код по адресу https://github.com/apple/ml-tarflow.