Физика в предсказании следующего токена: Передача информации и энергии в авто-регрессионных моделях

В настоящее время ведущие модели искусственного интеллекта (ИИ) в основном используют авто-регрессионную архитектуру. Эти модели, применяющие подход предсказания следующего токена (Next-token Prediction, NTP), интегрируют различные модальности — текст, изображения, аудио и видео — в единый процесс. Такая универсальность и интеллектуальность значительно меняют способы производства и жизни человека. Однако под этим многообещающим горизонтом скрывается "научная тьма". Следуя Закону масштабирования (Kaplan et al., 2020), исследователи стремятся создать всё большие обучающие наборы данных и тратить всё больше энергии на обучение авто-регрессионных моделей, чтобы достичь более "интеллектуальных" систем. Вопросы, которые мы рассматриваем в этой статье: почему большие данные и огромные вычислительные мощности приводят к появлению "интеллектуальности"? В чём суть этого феномена? Куда ведёт Закон масштабирования? Что ждёт нас на горизонте?

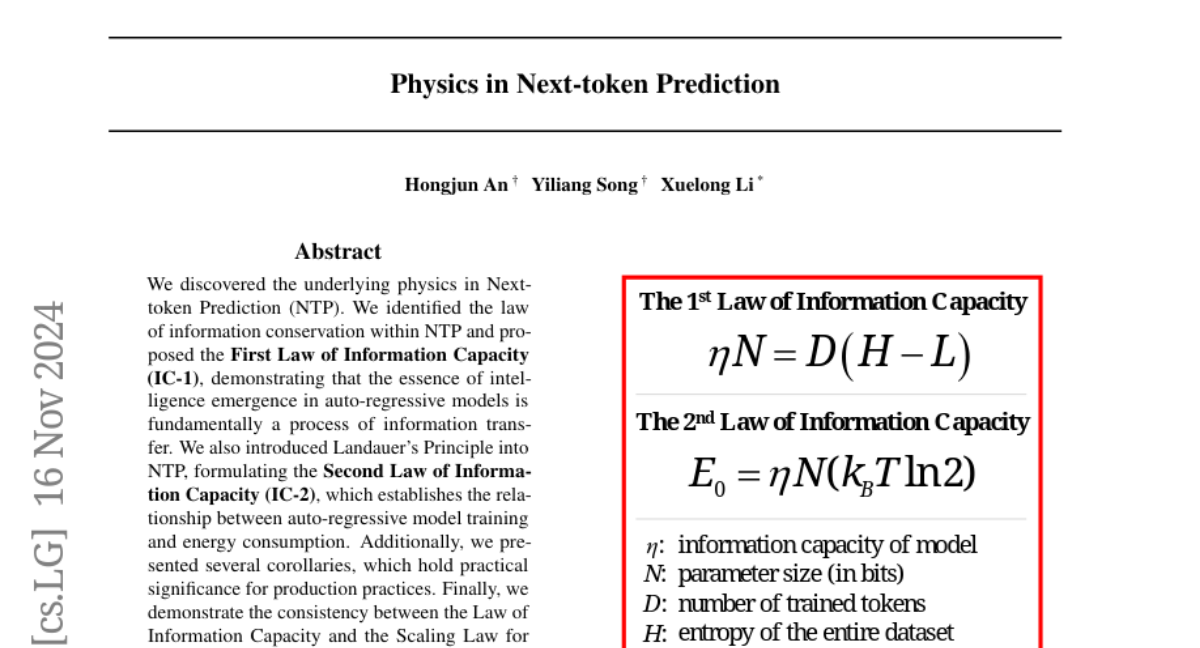

Первый закон информационной ёмкости: Закон сохранения информации в NTP

Предварительные сведения

В 2023 году Рэй (Rae, 2023) представил процесс NTP как механизм сжатия информации в наборе данных, объясняя связь между сжатием и возникновением интеллекта: дан словарь токенов V и набор данных D = {x1, x2, ..., x|D|} (xi ∈ V), наша цель — передать D от A к B токен за токеном с максимальной точностью. В процессе передачи обе стороны могут использовать общие функции кодирования и декодирования f. В этом разделе мы покажем, что уровень интеллекта функции f связан с её способностью сжимать D.

Базовый метод: НЕИНТЕЛЛЕКТУАЛЬНАЯ ПЕРЕДАЧА

Предположим, что мы передали D до t-го токена, D_t = {x1:t}, и собираемся передать x_t+1. Для неинтеллектуальной функции f_0, согласно теории информации (Shannon, 1948), длина кода z_f_0_t+1 = f_0(x_t+1 | x1:t) должна быть не менее −log P(x_t+1 | x1:t) (уравнение 1), что является его самостоятельной информацией.

| z_f_0_t+1 | = I(x_t+1 | x1:t) = −log P(x_t+1 | x1:t), (1)

где начальное условие — P(x1 | x0) = P(x1). Таким образом, общая стоимость передачи по этому методу равна I(D) (уравнение 2).

I(D) = |D| ∑_t=1 |z_f_0_t| = |D| ∑_t=1 −log P(x_t+1 | x1:t) = |D| H(D). (2)

Интеллектуальная передача на основе сжатия

Когда авто-регрессионные модели, такие как большие языковые модели (LLM), применяются для предсказания следующего токена, на каждой итерации они вводят x1:t и предсказывают P(x_t+1 | x1:t, f_a). Таким образом, общая стоимость передачи D по этому методу составляет не менее I(D|f_a) (уравнение 3).

I(D|f_a) = |D|−1 ∑_t=0 −log P(x_t+1 | x1:t, f_a). (3)

Отметим, что уравнение 3 точно соответствует функции потерь, оптимизируемой во время обучения — кросс-энтропийной функции потерь (уравнение 4).

ℓ(f_a) = 1/|D| ∑_t=0 |D|−1 −log P(x_t+1 | x1:t, f_a) = 1/|D| I(D|f_a). (4)

Таким образом, процесс обучения модели, характеризуемый снижением функции потерь, можно рассматривать как процесс сжатия набора данных D. Чем выше степень сжатия, тем интеллектуальнее становится модель.

Вывод Первого закона информационной ёмкости

Если мы внимательно изучим уравнения 2 и 4, мы можем обнаружить ещё более интересный вывод. Когда f_a достаточно мощная, I(D|f_a) вероятно будет меньше, чем I(D). Не означает ли это, что некоторая информация исчезает в воздухе (уравнение 5)?

I(D) − I(D|f_a) = ? (5)

На самом деле, с точки зрения физики, информация сохраняется (Hawking, 2014). Эти куски информации не исчезают, а переносятся в модель f_a (уравнение 6).

I(f_a+) = I(D) − I(D|f_a), (6)

где I(f_a+) представляет собой эффективную информацию, хранящуюся в f_a, относящуюся к задаче D. Мы вводим концепцию информационной ёмкости (Li & Zhao, 2021), обозначаемую η, которая определяется как отношение эффективной информации I(f_a+) к размеру данных N (примерно равному числу параметров, измеряемых в битах). Таким образом, мы получаем уравнение 7:

η = I(f_a+)/N. (7)

После выполнения эквивалентных преобразований уравнения 7 мы приходим к Первому закону информационной ёмкости (IC-1), как показано в уравнении 8:

ηN = D(H − L). (8)

где L = ℓ(f_a) обозначает среднюю кросс-энтропийную потерю, D = |D| обозначает количество токенов в наборе данных D, а H = H(D) обозначает энтропию всего набора данных. Таким образом, процесс обучения модели по сути является процессом сжатия набора данных D, что приводит к снижению функции потерь, переносу информации в модель f_a и увеличению её информационной ёмкости η. Этот перенос обусловлен процессом обучения модели, особенно алгоритмом обратного распространения ошибки (Rumelhart et al., 1986). Энергия для этого переноса поступает из электрических ресурсов реального мира (раздел 3).

Динамический взгляд на процесс возникновения интеллекта

В настоящее время уравнение 8 остаётся статичным. В частности, в нашем выводе D представляет собой общее количество токенов в наборе данных, H обозначает общую энтропию набора данных, а L — средняя потеря после завершения обучения. С точки зрения закона сохранения информации, важно, чтобы сохранение наблюдалось не только в конечном состоянии, но и на протяжении всего динамического процесса обучения. Поэтому мы переопределим значения переменных в уравнении 8:

- H: общая энтропия набора данных — это константа.

- N: размер параметров модели, измеряемый в битах. Как только архитектура модели установлена, она становится фиксированной константой.

- D: количество токенов, которые были обучены. Это переменная, которая монотонно увеличивается по мере прогресса обучения.

- η, L: η — информационная ёмкость модели, а L — динамическая средняя кросс-энтропийная потеря. Оба изменяются динамически по мере увеличения D.

Таким образом, можно описать весь процесс обучения модели с динамической точки зрения на основе IC-1:

Начальное состояние. Обучение ещё не началось, нет переноса информации, поэтому η = 0.

Состояние обучения. По мере прогресса обучения D постепенно увеличивается, что приводит к снижению L. Чтобы удовлетворить уравнение, η должна неизбежно увеличиваться. В этом динамическом процессе информация постепенно переносится в f_a, побуждая модель учиться.

Конечное состояние. Когда η = η_max (определяется архитектурой модели), информация, которую могут хранить параметры модели, достигает насыщения. В этот момент продолжение обучения не позволяет модели научиться обрабатывать больше токенов; L сходится, и обучение завершается.

Второй закон информационной ёмкости: Энергетическая связь в NTP

В разделе 2.2 IC-1 указывает, что процесс обучения в авто-регрессионных моделях по сути является процессом переноса информации. Сила, движущая этим переносом, исходит из алгоритма обратного распространения (Rumelhart et al., 1986), а энергия поступает из энергии физического мира. Возникает вопрос: каково минимальное количество энергии, необходимое для завершения этого процесса переноса информации?

В 1961 году Ландауэр предложил, что для стирания одного бита информации требуется энергия не менее k_B T ln2, известная как Принцип Ландауэра (Landauer, 1961). Следовательно, согласно уравнению 8, когда мы переносим информацию I(f_a+), должно быть потреблено как минимум энергии E_0 = I(f_a+) k_B T ln2. Таким образом, процесс обучения авто-регрессионных моделей устанавливает энергетическую связь с физическим миром. Мы можем вывести Второй закон информационной ёмкости (IC-2) (уравнение 9).

E_0 = ηN (k_B T ln2), (9)

где E_0 — это минимальная энергия, необходимая для завершения переноса информации, k_B ≈ 1.38 × 10^−23 J/K — это постоянная Больцмана, а T — температура теплового резервуара в Кельвинах.

Выводы

Эта статья раскрыла фундаментальные физические принципы, лежащие в основе NTP, установив IC-1 и IC-2. Эти законы не только объясняют сохранение информации и энергетические требования при обучении авто-регрессионных моделей, но и предлагают практические следствия, которые могут руководить разработкой и обучением интеллектуальных систем. Согласуя наши результаты с существующими теориями, мы продемонстрировали широкую применимость и значимость нашей теоретической рамки, тем самым прокладывая путь для более эффективных и устойчивых достижений в области искусственного интеллекта.