MIDI: Многоэкземплярное диффузионное моделирование для генерации 3D-сцен из одного изображения

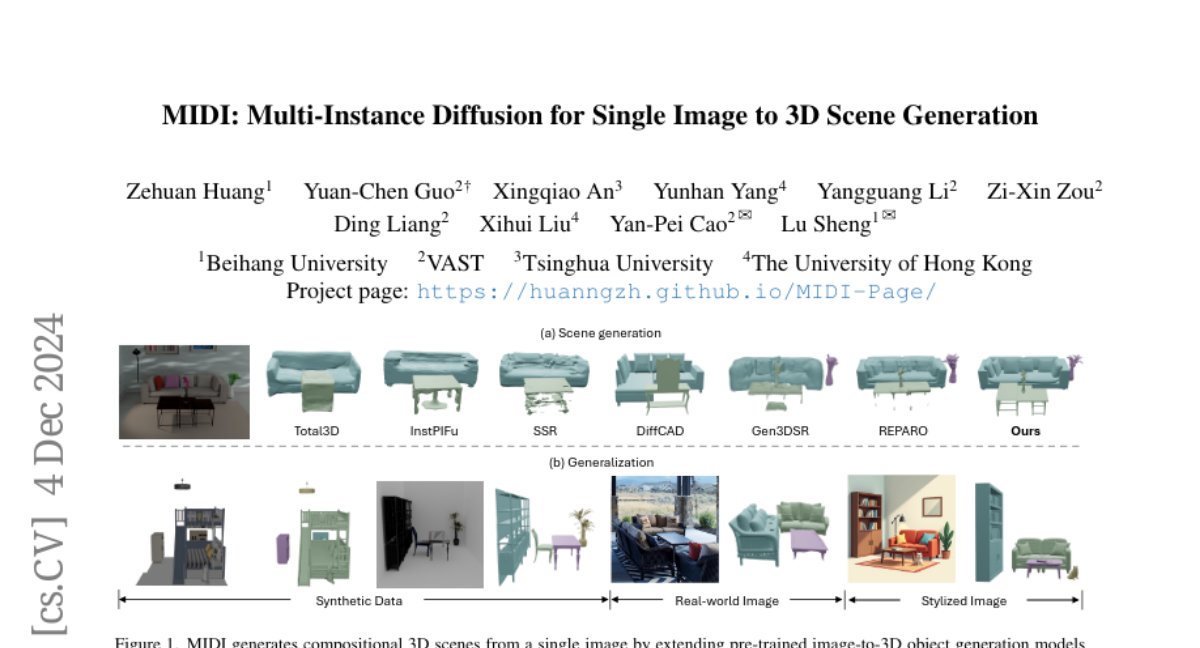

Данная работа представляет MIDI, новую парадигму для композиционной генерации 3D-сцен из одного изображения. В отличие от существующих методов, основанных на техниках реконструкции или поиска, или недавних подходов, использующих многоступенчатую генерацию объектов по отдельности, MIDI расширяет предварительно обученные модели генерации изображений в 3D-объекты до моделей диффузии с несколькими экземплярами, позволяя одновременно генерировать несколько 3D-экземпляров с точными пространственными отношениями и высокой обобщаемостью. В своей основе MIDI включает новую механизм многоэкземплярного внимания, который эффективно улавливает взаимодействия между объектами и пространственную когерентность прямо в процессе генерации, без необходимости в сложных многоступенчатых процессах. Метод использует частичные изображения объектов и глобальный контекст сцены в качестве входных данных, непосредственно моделируя завершение объектов во время генерации 3D. Во время обучения мы эффективно контролируем взаимодействия между 3D-экземплярами, используя ограниченное количество данных на уровне сцены, при этом включая данные по одиночным объектам для регуляризации, сохраняя тем самым способность к обобщению, присущую предварительно обученным моделям. MIDI демонстрирует достижения на уровне современного искусства в генерации изображений в сцены, что подтверждается оценками на синтетических данных, реальных сценах и стилизованных изображениях сцен, созданных моделями диффузии текстов в изображения.