MIDI: Многоэкземплярное диффузионное моделирование для генерации 3D-сцен из одного изображения

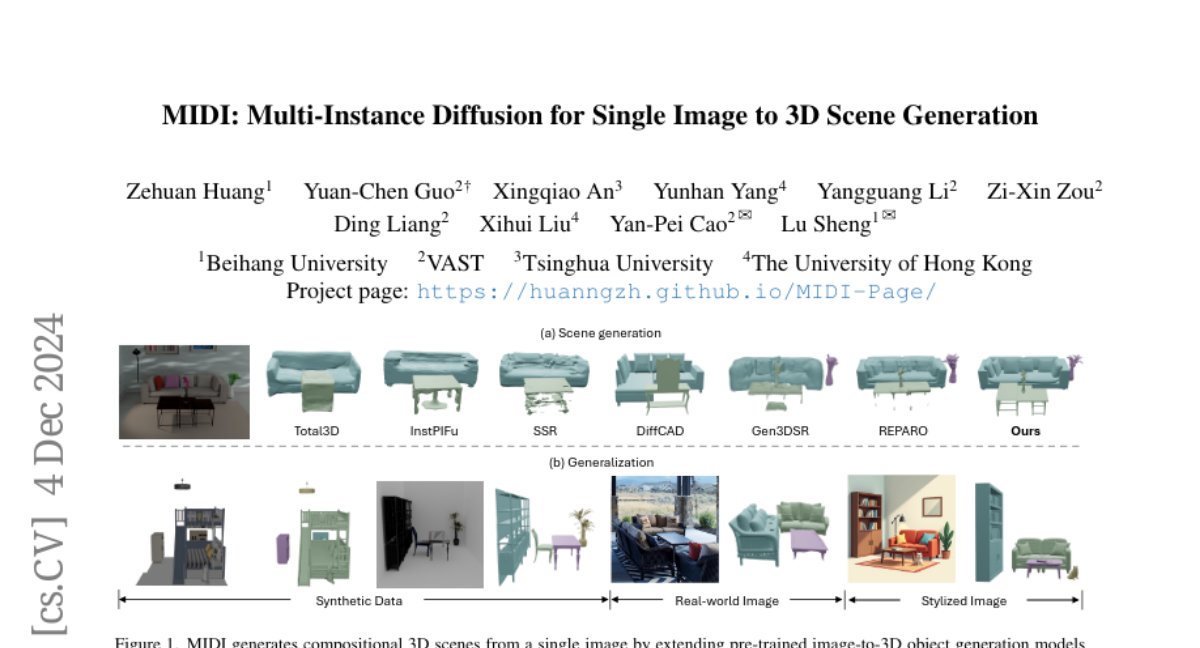

Генерация составных 3D-сцен из одного изображения представляет собой сложную задачу в области компьютерного зрения и машинного обучения. Традиционно существующие методы можно разделить на две основные категории: реконструкционные и основанные на извлечении. Оба подхода имеют свои ограничения, такие как недостаточная точность и неспособность обрабатывать новые объекты и сцены. В этой статье мы рассмотрим новый подход, предложенный в работе MIDI (Multi-Instance Diffusion for Single Image to 3D Scene Generation), который использует многоэкземплярное диффузионное моделирование для одновременной генерации нескольких 3D-объектов с учетом их пространственных отношений.

Проблематика существующих подходов

Реконструкционные методы

Реконструкционные методы, как правило, полагаются на нейронные сети, обученные на 3D-данных, чтобы предсказать геометрию сцены на основе одного изображения. Однако их производительность часто ограничена из-за нехватки обучающих данных и неспособности обобщать на новые, невидимые сцены. Эти методы часто страдают от низкого качества реконструкции, особенно в сложных или незнакомых условиях.

Методы извлечения

Методы извлечения хранят 3D-модели в базе данных и извлекают их для соответствия входному изображению. Однако они также сталкиваются с проблемами, связанными с недостаточностью информации, содержащейся в одном изображении, что приводит к неточным или неполным результатам. Кроме того, наличие ограниченного числа моделей в базе данных затрудняет точное соответствие с объектами на входном изображении.

Составные генерационные методы

Недавние составные генерационные методы пытаются решить эти проблемы, используя многослойные процессы генерации, которые включают сегментацию, завершение объектов и оптимизацию пространственных отношений. Однако такие подходы часто подвержены накоплению ошибок, и их сложные процессы могут привести к несоответствию между сгенерированными объектами и общей сценой.

MIDI: Новый подход к генерации 3D-сцен

MIDI представляет новый парадигму для генерирования 3D-сцен, основанную на многоэкземплярных диффузионных моделях. Этот подход позволяет одновременно создавать несколько 3D-объектов, учитывая их пространственные отношения, что значительно повышает эффективность и точность генерации.

Архитектура MIDI

В основе MIDI лежит многоэкземплярное внимание, которое позволяет эффективно моделировать взаимодействия между объектами и пространственную согласованность в процессе генерации. Вместо того чтобы генерировать объекты по одному, MIDI использует параллельное денойзинг-обучение, что позволяет моделировать сложные взаимодействия между объектами в 3D-пространстве.

Многоэкземплярное внимание

Механизм многоэкземплярного внимания расширяет традиционное внимание, позволяя каждому экземпляру учитывать информацию от всех других экземпляров в сцене. Это обеспечивает более глубокое понимание пространственных отношений и взаимодействий между объектами, что критически важно для создания согласованных и реалистичных 3D-сцен.

Процесс обучения

MIDI использует ограниченное количество данных на уровне сцены для эффективного обучения взаимодействий между 3D-экземплярами. В дополнение к этому, данные об отдельных объектах используются для регуляризации, что помогает сохранить способность к обобщению модели.

Эксперименты и результаты

Настройка экспериментов

Для оценки эффективности MIDI были проведены эксперименты на синтетических и реальных данных. Использовались различные метрики, такие как расстояние Шамфера и F-Score, для оценки качества сгенерированных сцен.

Синтетические данные

На синтетических наборах данных, таких как 3D-Front и BlendSwap, MIDI показал выдающиеся результаты, превосходя существующие методы по всем оцененным метрикам. Это подтверждает, что использование многоэкземплярного внимания и предварительно обученных моделей 3D-объектов позволяет значительно улучшить качество генерации.

Реальные изображения

MIDI также был протестирован на реальных изображениях из наборов данных Matterport3D и ScanNet. Результаты показали, что модель успешно генерирует сцены с высокой точностью и полнотой, что подчеркивает ее потенциал для применения в реальных условиях.

Генерация из стилизованных изображений

Чтобы дополнительно оценить способности к обобщению MIDI, модель была протестирована на сценах, сгенерированных текстово-изображенческими диффузионными моделями. MIDI продемонстрировал свою способность генерировать точные и согласованные 3D-сцены из разнообразных входных изображений, что подтверждает его универсальность.

Заключение и будущее работы

MIDI представляет собой значительный шаг вперед в области генерации 3D-сцен из одного изображения. Используя многоэкземплярное диффузионное моделирование и механизм многоэкземплярного внимания, модель эффективно захватывает сложные взаимодействия между объектами и пространственную согласованность, что позволяет одновременно генерировать несколько 3D-экземпляров с точными пространственными отношениями.

Будущие исследования могут сосредоточиться на расширении подхода для моделирования более сложных взаимодействий в составных сценах, таких как взаимодействия персонажей с объектами, а также на интеграции явных 3D-геометрических знаний для разработки более эффективных механизмов внимания.