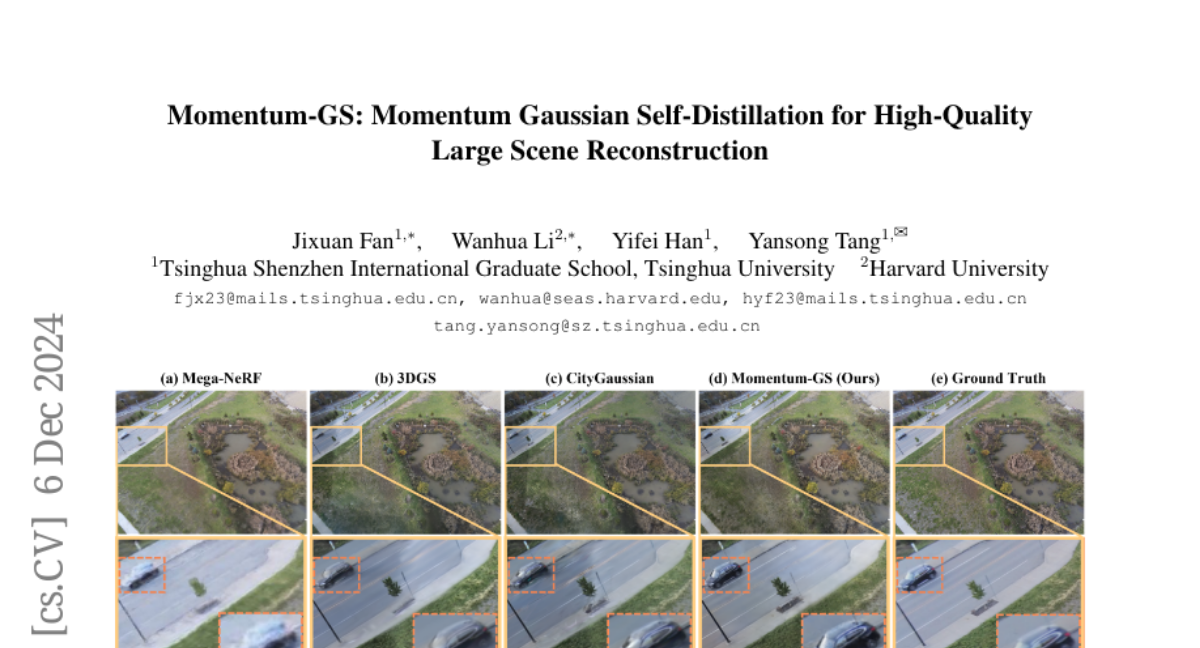

Momentum-GS: Моментное гауссовское самоотделение для высококачественной реконструкции больших сцен

3D Gaussian Splatting продемонстрировал значительный успех в реконструкции сцен большого масштаба, однако существуют проблемы из-за высокого потребления памяти при обучении и накладных расходов на хранение. Гибридные представления, которые интегрируют неявные и явные характеристики, предлагают способ смягчить эти ограничения. Однако при применении параллельного блочного обучения возникают две критические проблемы, так как точность реконструкции ухудшается из-за снижения разнообразия данных при независимом обучении каждого блока, а параллельное обучение ограничивает количество деленных блоков доступным числом графических процессоров (GPU). Чтобы решить эти проблемы, мы предлагаем Momentum-GS, новый подход, который использует самодистилляцию на основе импульса, чтобы способствовать согласованности и точности между блоками, одновременно отделяя количество блоков от физического числа GPU. Наш метод поддерживает учительский гауссов декодер, обновляемый с помощью импульса, обеспечивая стабильную отправную точку во время обучения. Этот учитель предоставляет каждому блоку глобальную направляющую в манере самодистилляции, способствуя пространственной согласованности в реконструкции. Чтобы дополнительно обеспечить согласованность между блоками, мы внедряем взвешивание блоков, динамически регулируя вес каждого блока в зависимости от его точности реконструкции. Обширные эксперименты на сценах большого масштаба показывают, что наш метод последовательно превосходит существующие техники, достигая 12.8% улучшения в LPIPS по сравнению с CityGaussian с гораздо меньшим количеством деленных блоков и устанавливая новый эталон. Страница проекта: https://jixuan-fan.github.io/Momentum-GS_Page/