Введение в GPT-BERT: Гибридный подход к языковому моделированию

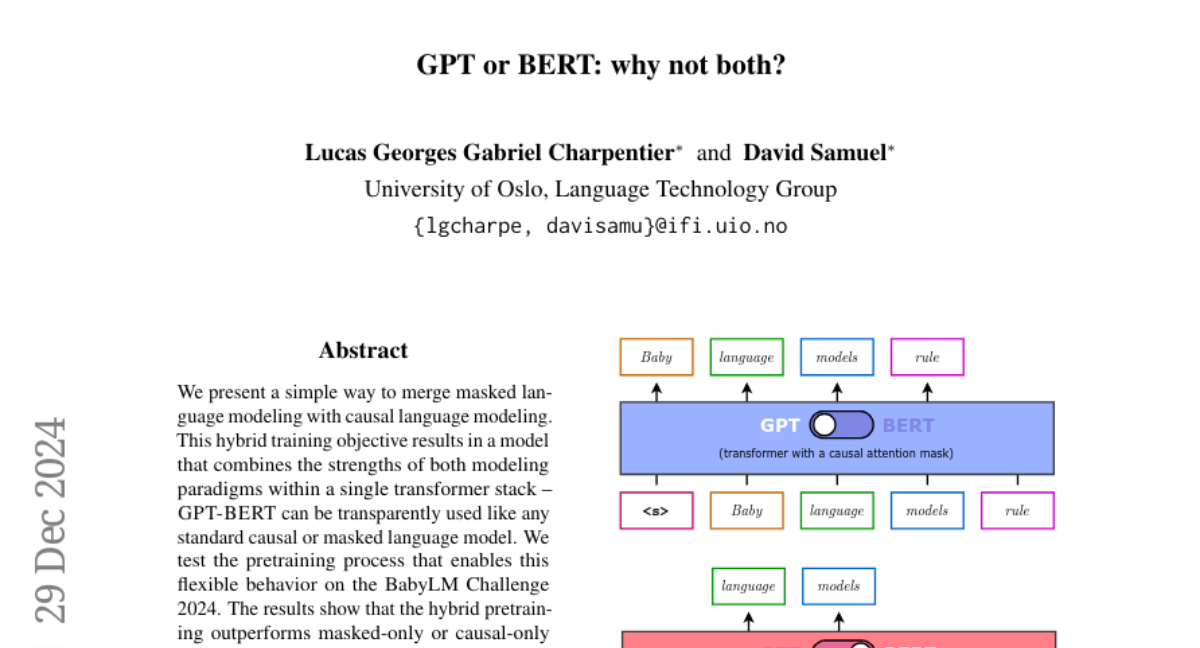

В последние годы языковые модели стали неотъемлемой частью обработки естественного языка (NLP), предоставляя инструменты для понимания и генерации текста. Среди них выделяются две основные парадигмы: каузальные языковые модели (CLM) и маскированные языковые модели (MLM). Эти подходы имеют свои уникальные преимущества и недостатки, что привело к созданию различных архитектур, таких как GPT (Generative Pretrained Transformer) и BERT (Bidirectional Encoder Representations from Transformers). В этой статье мы рассмотрим новую архитектуру, названную GPT-BERT, которая объединяет оба эти подхода в одной трансформерной модели.

Исторический контекст

История современных языковых моделей началась с работы Радфорда и его коллег в 2018 году, когда они представили модель GPT, которая продемонстрировала впечатляющие способности к генерации текста. Вскоре после этого, в 2019 году, Девлин и другие ввели BERT, который показал значительное превосходство в задачах понимания естественного языка благодаря своему бидирекционному подходу к маскированному языковому моделированию. Эти модели определили основные направления в NLP, но каждый из них имеет свои ограничения.

Краткий обзор GPT и BERT

-

GPT: Использует каузальное моделирование, где модель предсказывает следующий токен, основываясь только на предыдущих токенах. Это делает её идеальной для генерации текста, но она ограничена в понимании контекста, так как не учитывает будущие токены.

-

BERT: Использует маскированное моделирование, где модель обучается восстанавливать случайно маскированные токены в предложении. Это позволяет ей учитывать контекст как слева, так и справа от маскированного токена, что улучшает её понимание языка.

GPT-BERT: Гибридный подход

Концепция

Идея GPT-BERT заключается в том, чтобы объединить преимущества обеих парадигм в одной модели. Это достигается путем изменения способа обработки выходных токенов в MLM. Вместо того чтобы предсказывать маскированные токены на их исходных позициях, предсказания смещаются на одну позицию вправо, что позволяет модели работать как в маскированном, так и в каузальном режиме без необходимости в архитектурных изменениях или дополнительных параметрах.

Реализация

-

Маскированное моделирование с предсказанием следующего токена (MNTP): Вместо традиционного MLM, где модель предсказывает маскированные токены в их исходных позициях, в MNTP предсказание маскированного токена происходит на следующей позиции. Это выравнивает выходные данные с CLM, где модель всегда предсказывает следующий токен.

-

Обработка данных: Датасет дублируется, один для каузального обучения, другой для маскированного. Это позволяет модели видеть все данные для обоих типов обучения.

-

Потери и архитектура: Обе задачи обучения минимизируют кросс-энтропийную потерю, используя один и тот же трансформерный энкодер/декодер.

Преимущества

- Универсальность: Модель может работать как в маскированном, так и в каузальном режиме, что делает её более гибкой для различных задач NLP.

- Эффективность: Объединение двух подходов в одной модели не требует дополнительных ресурсов или параметров, что делает обучение более эффективным.

- Улучшенное понимание контекста: Сочетание бидирекционного и каузального обучения позволяет модели лучше понимать контекст и генерировать более точные и контекстно-зависимые тексты.

Эксперименты и результаты

BabyLM Challenge 2024

Мы провели эксперименты на BabyLM Challenge 2024, который предоставляет контролируемую среду для сравнения языковых моделей, обученных на ограниченных данных. Наши результаты показали, что гибридный подход GPT-BERT превосходит модели, обученные только на маскированных или только на каузальных данных.

Оценка

Мы оценили модель по нескольким критериям:

- BLiMP: Задачи, требующие понимания синтаксиса языка.

- GLUE и SuperGLUE: Наборы задач для оценки общего понимания языка.

- EWOK: Задачи, требующие понимания элементов мирового знания.

Результаты

- На всех треках BabyLM Challenge 2024 модель GPT-BERT показала лучшие или сравнимые результаты по сравнению с моделями ELC-BERT и LTG-BERT, особенно выделяясь в задачах, требующих глубокого понимания языка и контекста.

Влияние соотношения MLM и CLM

Мы также исследовали, как различное соотношение между маскированным и каузальным обучением влияет на производительность модели. Результаты показали, что оптимальное соотношение обеспечивает наилучшую производительность в различных задачах, подтверждая, что гибридный подход может быть настроен для конкретных приложений.

Заключение

GPT-BERT представляет собой инновационный подход к языковому моделированию, объединяя силу маскированного и каузального обучения в одной архитектуре. Этот гибрид позволяет модели быть более универсальной и эффективной, что подтверждается результатами на различных бенчмарках. Будущее NLP может значительно выиграть от таких унифицированных подходов, которые не только улучшают производительность, но и делают модели более адаптируемыми к широкому спектру задач.