Сильные модели не всегда лучшие учителя для настройки на инструкции

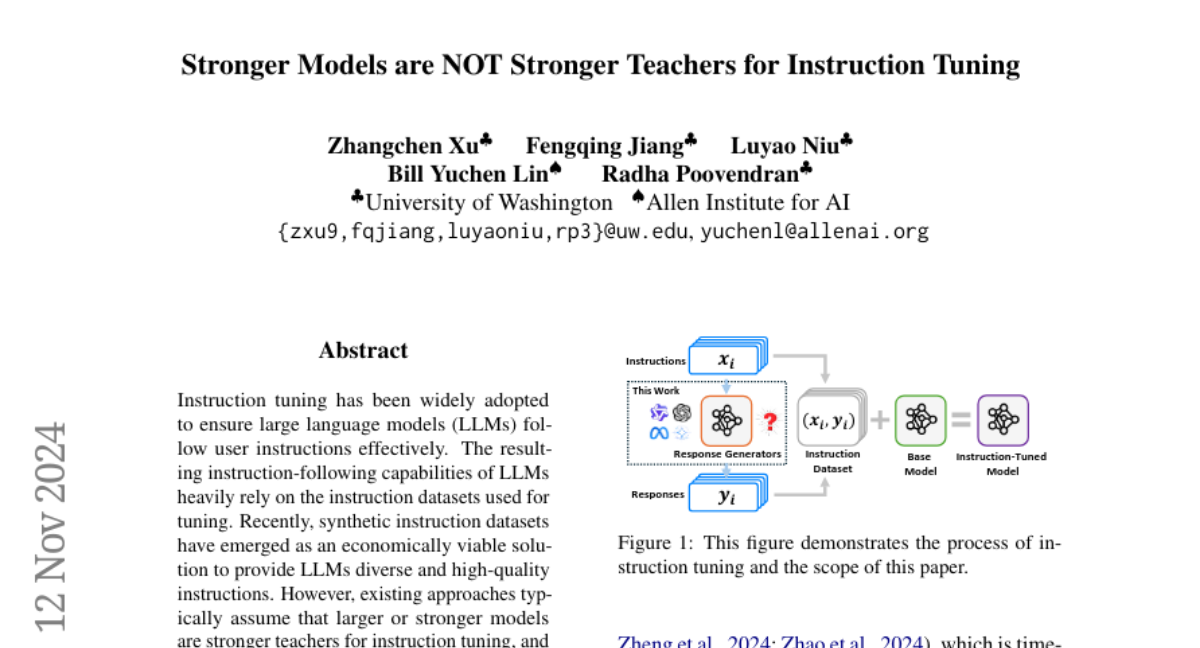

**Настройка инструкций широко используется для того, чтобы обеспечить эффективное выполнение инструкций пользователей большими языковыми моделями (LLM). Способности LLM к следованию инструкциям в значительной степени зависят от используемых для настройки наборов данных инструкций. Недавно появились синтетические наборы данных инструкций, которые представляют собой экономически выгодное решение для предоставления LLM разнообразных и качественных инструкций. Однако существующие подходы обычно предполагают, что более крупные или более мощные модели являются более эффективными учителями для настройки инструкций, и поэтому просто используют эти модели в качестве генераторов ответов на синтетические инструкции. В данной статье мы оспариваем это широко принятое предположение. Наши обширные эксперименты с пятью базовыми моделями и двадцатью генераторами ответов показали, что более крупные и мощные модели не всегда являются лучшими учителями для более мелких моделей. Мы называем это явление парадоксом больших моделей. Мы наблюдаем, что существующие метрики не могут точно предсказать эффективность генераторов ответов, поскольку они игнорируют совместимость между учителями и настраиваемыми базовыми моделями. Поэтому мы разработали новую метрику под названием Компенсируемое Совместимостью Вознаграждение (CAR), чтобы измерить эффективность генераторов ответов. Наши эксперименты с пятью базовыми моделями показывают, что CAR превосходит почти все базовые методы.**