Сильные модели не всегда лучшие учителя для настройки на инструкции

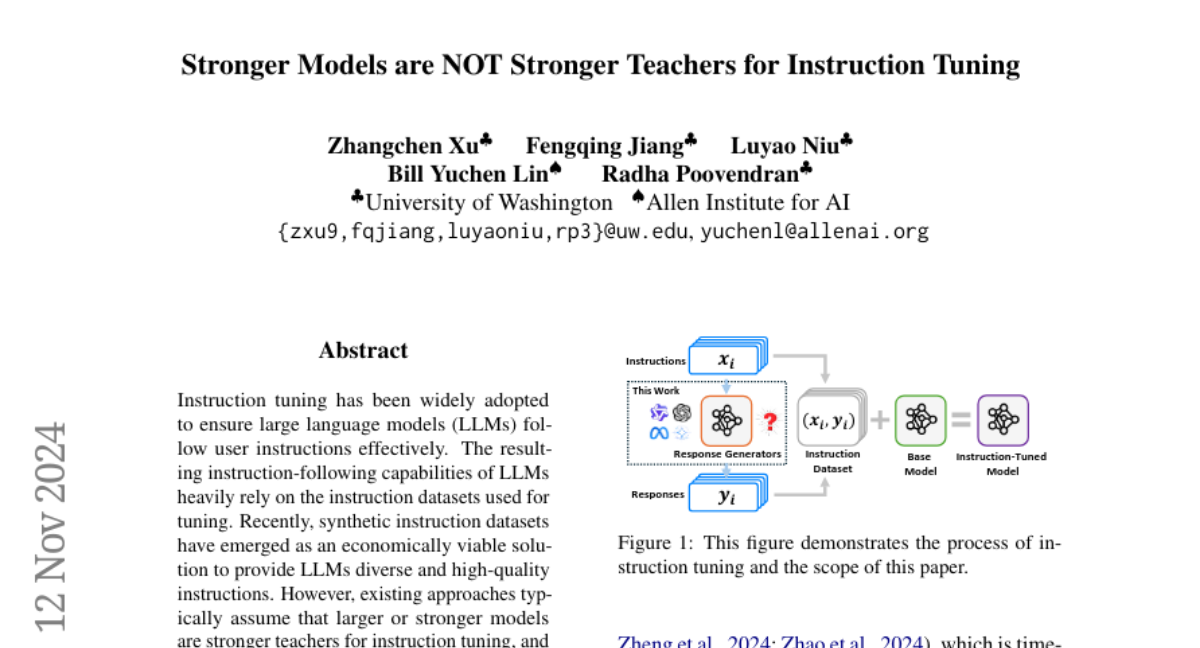

Настройка на инструкции (instruction tuning) стала ключевым методом для улучшения способности больших языковых моделей (LLMs) следовать инструкциям пользователей. Этот процесс включает в себя использование специализированных наборов данных, где каждая запись состоит из инструкции и соответствующего ответа. Эффективность настройки на инструкции во многом зависит от качества и разнообразия этих наборов данных.

В последние годы синтетические наборы данных, созданные самими LLM, стали экономически выгодным решением для обеспечения моделей высококачественными инструкциями. Однако, несмотря на очевидные преимущества, существует предположение, что более крупные или сильные модели должны быть лучшими учителями для настройки на инструкции. В данной статье мы бросаем вызов этому предположению, исследуя, действительно ли большие модели всегда являются наилучшими учителями для меньших моделей.

Исследовательские вопросы

-

Какие модели являются наиболее эффективными генераторами ответов для настройки на инструкции?

- Мы исследовали 20 генераторов ответов из семи семейств моделей, включая Qwen2, Qwen2.5, Llama3, Llama3.1, Gemma2, Phi-3 и GPT-4, чтобы определить, какие из них наиболее эффективны.

-

Как можно определить наиболее эффективные генераторы ответов для определенной базовой модели без необходимости настройки на инструкции?

- Мы разработали новую метрику, названную Compatibility-Adjusted Reward (CAR), которая учитывает совместимость между генератором ответов и базовой моделью.

Экспериментальная установка

Наборы инструкций

Для наших экспериментов мы использовали два набора инструкций:

- Magpie-100K: Подмножество из 100,000 высококачественных инструкций из набора данных Magpie-Air-3M.

- Mix-100K: Смешанный набор из 100,000 инструкций, включающий как человеческие, так и синтетические инструкции из различных источников.

Генераторы ответов

Мы рассмотрели 20 генераторов ответов, охватывающих семь семейств моделей. Эти модели различаются по размеру и архитектуре, что позволило нам оценить влияние различных параметров на качество генерируемых ответов.

Базовые модели

Для настройки на инструкции мы выбрали пять базовых моделей различного размера и происхождения:

- Qwen2-1.5B

- Gemma-2-2b

- Llama-3.2-3B

- Qwen2.5-3B

- Llama-3.1-Minitron-4B-Width-Base

Оценка производительности

Для оценки способности моделей следовать инструкциям мы использовали два бенчмарка:

- AlpacaEval 2 (AE2): Содержит 805 инструкций, отражающих реальные запросы пользователей.

- Arena-Hard (AH): Содержит 500 сложных запросов пользователей.

Оценка проводилась с использованием метрик, таких как win rate (WR) и length-controlled win rate (LC), а также средней производительности (AP), которая является средним значением LC из AE2 и WR из AH.

Эмпирическая оценка

Основные выводы

-

Парадокс больших моделей: Мы обнаружили, что увеличение размера модели генератора ответов не всегда приводит к улучшению способности базовой модели следовать инструкциям. Этот феномен мы назвали "Парадоксом больших моделей".

-

Семейная помощь: Базовые модели показали лучшие результаты, когда настраивались на ответы, сгенерированные моделями из того же семейства.

-

Открытые модели превосходят закрытые: Открытые модели, такие как Gemma-2 и Qwen2, часто превосходили закрытые модели, такие как GPT-4, в качестве генераторов ответов.

-

Влияние температуры и top-p: Высокие значения температуры и top-p при генерации ответов улучшали способность моделей следовать инструкциям.

-

Результаты отклонения выборки: Использование отклонения выборки (reject sampling) приводило к небольшому улучшению производительности по сравнению с обычными методами семплирования.

Парадокс больших моделей

Наши эксперименты показали, что модели большего размера не всегда обеспечивают лучшие результаты для настройки на инструкции. Например, Gemma-2-9b-it превосходила Gemma-2-27b-it в большинстве случаев, несмотря на то, что последняя модель значительно больше по размеру. Аналогичные результаты были получены для других семейств моделей, таких как Phi-3 и Llama3.

Семейная помощь и совместимость

Мы обнаружили, что модели, настроенные на ответы, сгенерированные моделями из того же семейства, показывают более высокую производительность. Это может быть связано с совместимостью архитектур и обученных представлений между моделями одного семейства.

Открытые модели против закрытых

В наших экспериментах открытые модели, такие как Gemma-2-9b-it и Qwen2.5-72B-Instruct, значительно превосходили GPT-4 в качестве генераторов ответов. Это может быть связано с тем, что ответы, генерируемые открытыми моделями, были длиннее и, возможно, более подробными, что предпочтительно для оценщиков.

Влияние гиперпараметров

Использование более высоких значений температуры и top-p при генерации ответов улучшало производительность моделей, вероятно, за счет увеличения разнообразия и контекстной насыщенности ответов.

Отклонение выборки

Таблица 3 показывает, что отклонение выборки может немного улучшить производительность моделей по сравнению с обычными методами семплирования, что подтверждает важность качества ответов для настройки на инструкции.

Метрика эффективности генераторов ответов

Определение эффективности

Мы определили эффективность генераторов ответов как способность улучшать инструкционные возможности базовой модели без необходимости проведения настройки. Для этого мы использовали коэффициент корреляции Спирмена (Spearman’s rank correlation coefficient) для оценки связи между предсказанным и фактическим рангом производительности.

Базовые методы

Мы рассмотрели несколько метрик для оценки эффективности генераторов ответов:

- Качество ответов: Оценивалось с помощью моделей вознаграждения (reward models).

- Сложность следования инструкциям: Измерялась с помощью перплексии ответов и метрики Instruction Following Difficulty (IFD).

- Длина ответов: Изучалась как фактор, влияющий на производительность.

Недостатки базовых методов

Наши результаты показали, что существующие метрики не могут точно предсказать эффективность генераторов ответов, поскольку они не учитывают совместимость между генератором и базовой моделью. Например, качество ответов, измеренное моделями вознаграждения, не всегда коррелировало с улучшением инструкционных способностей моделей.

Новая метрика: Compatibility-Adjusted Reward (CAR)

Мы предложили новую метрику, называемую Compatibility-Adjusted Reward (CAR), которая учитывает как качество ответов, так и их совместимость с базовой моделью. CAR вычисляется следующим образом:

[ \text{CAR}(D_i, \theta) = r(D_i) \cdot (1 + \beta \cdot L(D_i, \theta)) ]

где ( r(D_i) ) — среднее вознаграждение, измеренное моделью вознаграждения, ( L(D_i, \theta) ) — средняя потеря ответов на базовой модели, а ( \beta ) — параметр, регулирующий влияние совместимости.

Результаты экспериментов

Таблица 4 демонстрирует, что наша предложенная метрика CAR превосходит все базовые метрики по корреляции между эффективностью генератора ответов и инструкционными способностями настроенных моделей.

Заключение и направления для будущих исследований

В этом исследовании мы выявили "Парадокс больших моделей", показав, что большие модели не всегда являются лучшими учителями для настройки на инструкции. Мы также предложили новую метрику CAR, которая учитывает совместимость между генератором ответов и базовой моделью, что позволяет более точно предсказывать эффективность генераторов ответов.

Для будущих исследований мы предлагаем следующие направления:

- Эффективное преобразование существующих наборов данных для улучшения их совместимости с базовыми моделями.

- Теоретическое исследование совместимости для глубже понимания механизмов настройки на инструкции.

- Исследование влияния генераторов ответов на настройку предпочтений, что может помочь в лучшем отражении человеческих ценностей в LLM.

Таким образом, наши выводы и предложенная метрика могут служить руководством для будущей настройки LLM на инструкции, подчеркивая важность совместимости между моделями и генераторами ответов.