Mogo: Иерархический Каскадный Трансформер для Генерации 3D Движений Человека

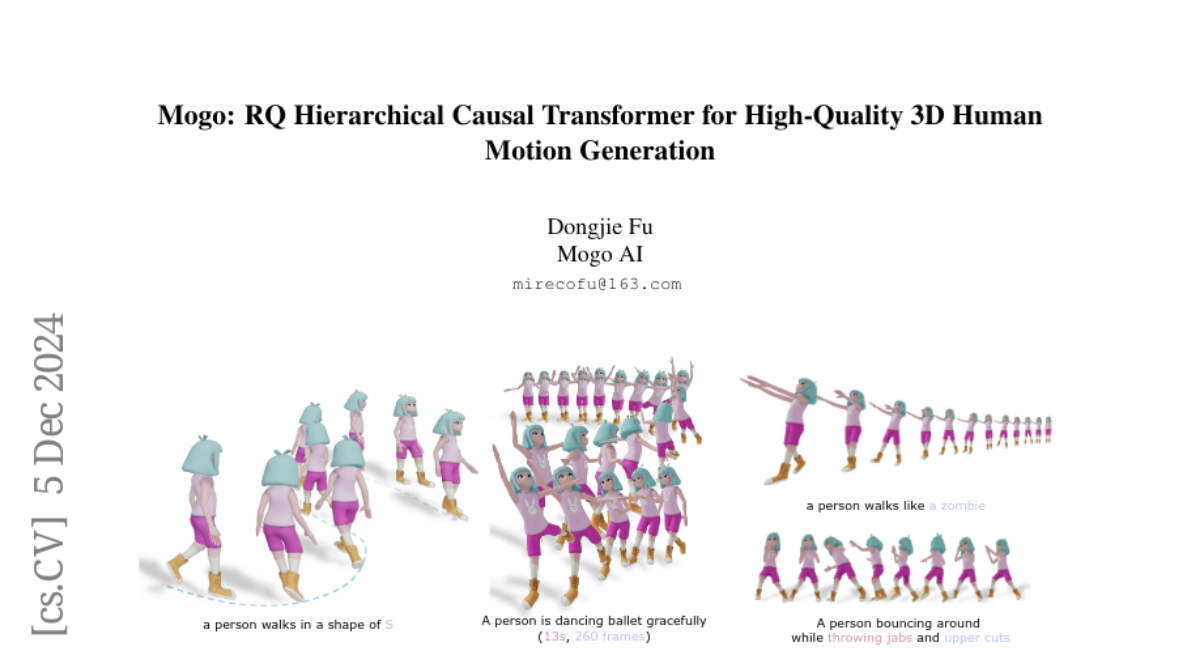

В области генерации текста в движение модели маскированного типа Bert (MoMask, MMM) в настоящее время производят более качественные результаты по сравнению с автогенеративными моделями типа GPT (T2M-GPT). Однако эти модели типа Bert часто не обладают возможностью потокового вывода, необходимой для применения в видеоиграх и мультимедийных средах, что является внутренней особенностью моделей типа GPT. Кроме того, они демонстрируют более слабую производительность в генерации вне распределения. Чтобы превзойти качество моделей типа BERT, используя структуру типа GPT, не добавляя дополнительных моделей уточнения, которые усложняют масштабирование данных, мы предлагаем новую архитектуру Mogo (Motion Only Generate Once), которая генерирует высококачественные реалистичные 3D движения человека, обучая единственную модель трансформера. Mogo состоит только из двух основных компонентов: 1) RVQ-VAE, иерархический резидульный векторный квантизационный вариационный автокодировщик, который дискретизирует непрерывные последовательности движения с высокой точностью; 2) Иерархический каузальный трансформер, отвечающий за генерирование базовых последовательностей движения авторегрессивным способом, одновременно выводя остатки через разные слои. Экспериментальные результаты демонстрируют, что Mogo может генерировать непрерывные и циклические последовательности движения до 260 кадров (13 секунд), превышая ограничение длины в 196 кадров (10 секунд) существующих наборов данных, таких как HumanML3D. На тестовом наборе HumanML3D Mogo достигает FID-оценки 0.079, превышая как модель типа GPT T2M-GPT (FID = 0.116), так и AttT2M (FID = 0.112), а также модель типа BERT MMM (FID = 0.080). Более того, наша модель демонстрирует лучшее количественное выполнение в генерации вне распределения.