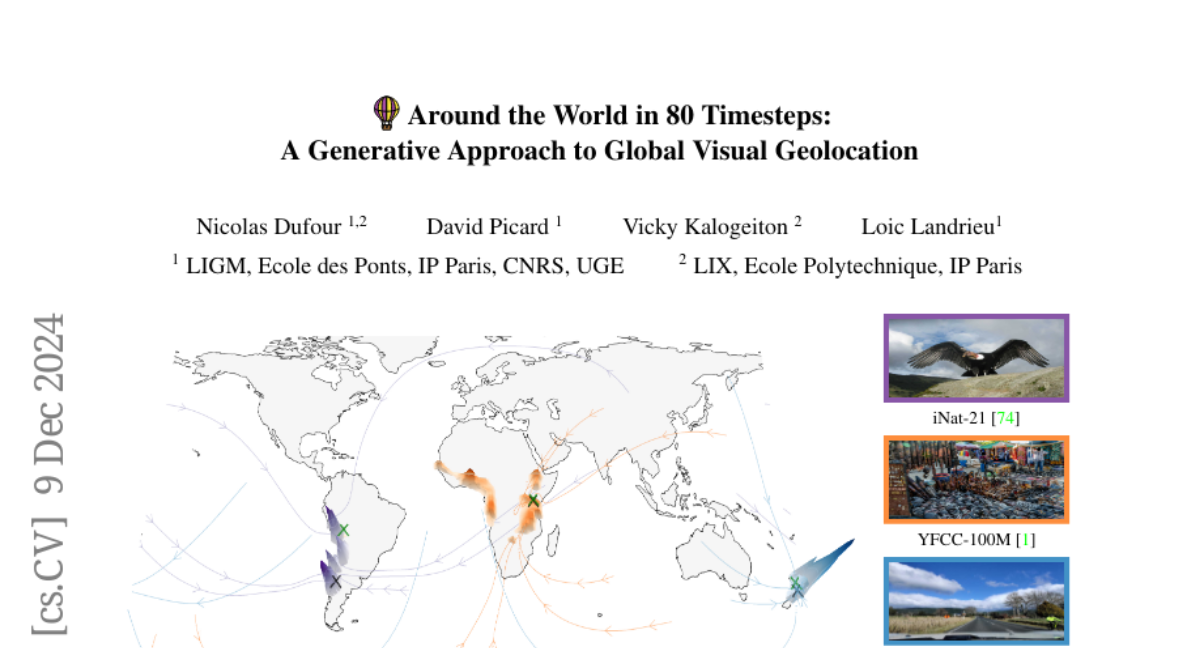

Вокруг света за 80 временных шагов: Генеративный подход к глобальной визуальной геолокации

Глобальная визуальная геолокация предсказывает, где изображение было сделано на Земле. Поскольку изображения различаются по точности локализации, эта задача изначально связана с значительной степенью неоднозначности. Тем не менее, существующие подходы являются детерминистическими и не учитывают этот аспект. В данной статье мы стремимся сократить разрыв между традиционной геолокацией и современными генеративными методами. Мы предлагаем первый генеративный подход к геолокации, основанный на диффузии и совпадении Римановых потоков, где процесс денойзинга осуществляется непосредственно на поверхности Земли. Наша модель достигает передовых показателей на трех тестах визуальной геолокации: OpenStreetView-5M, YFCC-100M и iNat21. Кроме того, мы вводим задачу вероятностной визуальной геолокации, где модель предсказывает распределение вероятностей по всем возможным локациям, вместо одной точки. Мы представляем новые метрики и базовые показатели для этой задачи, демонстрируя преимущества нашего подхода на основе диффузии. Код и модели будут доступны.