Интерпретация больших мультимодальных моделей: Разбор и управление внутренними представлениями

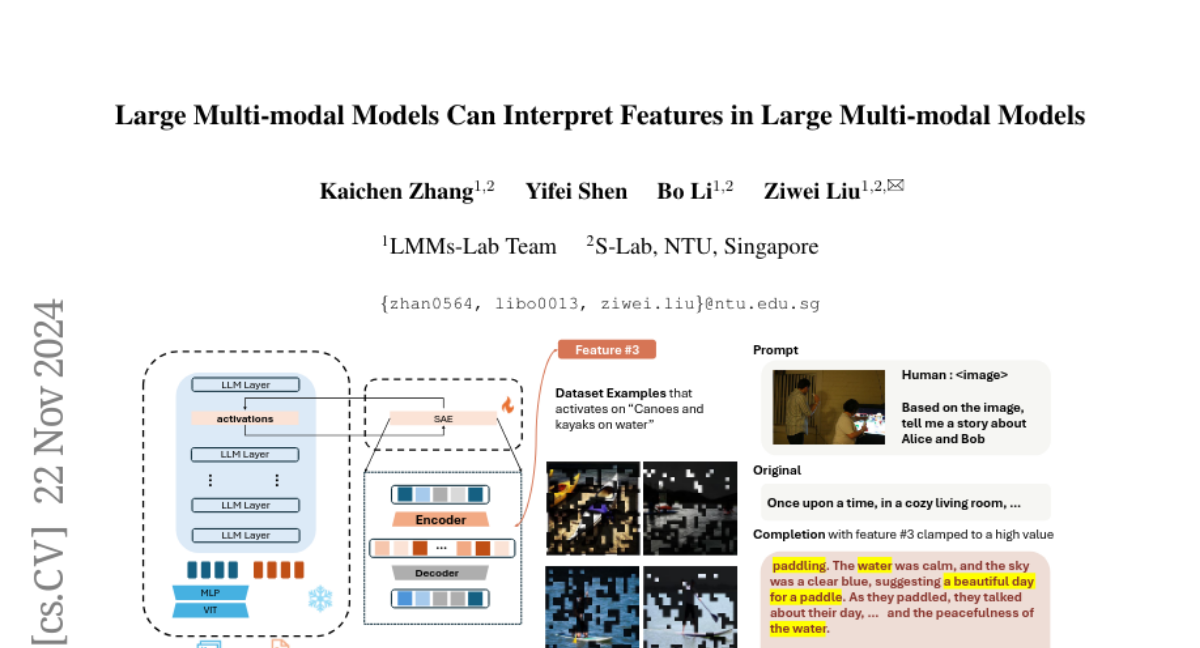

Недавние достижения в области крупных мультимодальных моделей (LMMs) привели к значительным прорывам как в академической среде, так и в промышленности. Возникает вопрос, как мы, как люди, можем понять их внутренние нейронные представления. В данной статье делается первый шаг к ответу на этот вопрос путем представления универсальной структуры для идентификации и интерпретации семантики внутри LMMs. В частности: 1) Сначала мы применяем разреженный автоэнкодер (SAE) для разделения представлений на понятные человеку характеристики. 2) Затем мы представляем автоматическую систему интерпретации для понимания открытых семантических характеристик, изученных SAE самими LMMs. Мы используем эту систему для анализа модели LLaVA-NeXT-8B с использованием модели LLaVA-OV-72B, демонстрируя, что эти характеристики могут эффективно направлять поведение модели. Наши результаты способствуют более глубокому пониманию того, почему LMMs превосходят в выполнении определенных задач, включая тесты на эмоциональный интеллект, и освещают природу их ошибок, а также потенциальные стратегии их исправления. Эти открытия предоставляют новые взгляды на внутренние механизмы LMMs и предполагают параллели с когнитивными процессами человеческого мозга.