Новый фреймворк федеративного обучения против атак инверсии градиентов

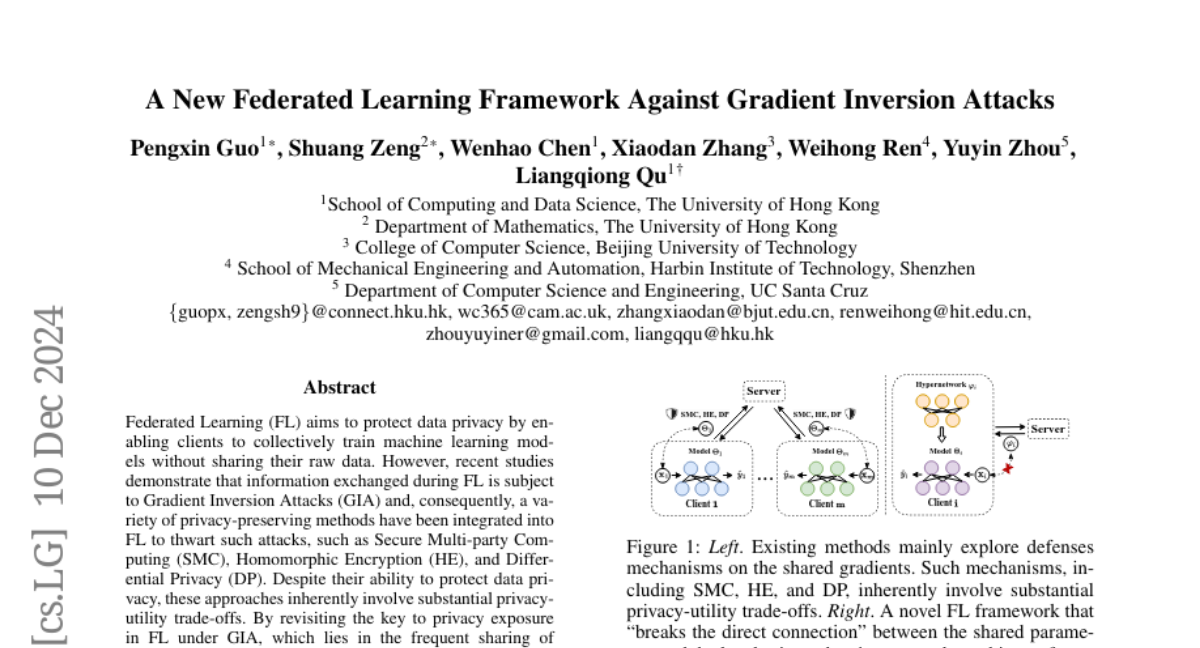

Федеративное обучение (FL) нацелено на защиту конфиденциальности данных, позволяя клиентам совместно обучать модели машинного обучения без обмена своими сырыми данными. Тем не менее, недавние исследования показывают, что информация, обменяемая в процессе FL, подвержена атакам инверсии градиента (GIA), и, следовательно, различные методы защиты конфиденциальности были интегрированы в FL для предотвращения таких атак, такие как безопасные вычисления с участием нескольких сторон (SMC), гомоморфное шифрование (HE) и дифференциальная конфиденциальность (DP). Несмотря на их способность защищать конфиденциальность данных, эти подходы по своей природе включают значительные компромиссы между конфиденциальностью и полезностью. Переосмысливая ключ к раскрытию конфиденциальности в FL в условиях GIA, который заключается в частом обмене градиентами модели, содержащими личные данные, мы принимаем новую перспективу, разрабатывая новую структуру FL, сохраняющую конфиденциальность, которая эффективно "разрывает прямую связь" между общими параметрами и локальными личными данными для защиты от GIA. В частности, мы предлагаем структуру федеративного обучения с гиперсетями (HyperFL), которая использует гиперсети для генерации параметров локальной модели, и только параметры гиперсети загружаются на сервер для агрегации. Теоретические анализы демонстрируют скорость сходимости предложенной структуры HyperFL, в то время как обширные экспериментальные результаты показывают возможность сохранения конфиденциальности и сопоставимую производительность HyperFL. Код доступен на https://github.com/Pengxin-Guo/HyperFL.