Новый фреймворк федеративного обучения против атак инверсии градиентов

Федеративное обучение (FL) представляет собой подход, позволяющий разным клиентам совместно обучать модели машинного обучения, не передавая свои данные на центральный сервер. Это особенно важно в условиях растущих требований к конфиденциальности данных и соблюдения норм законодательства. Однако, несмотря на свои преимущества, FL сталкивается с угрозами, такими как атаки инверсии градиентов (GIA), которые могут восстанавливать частные данные клиентов на основе обмена градиентами.

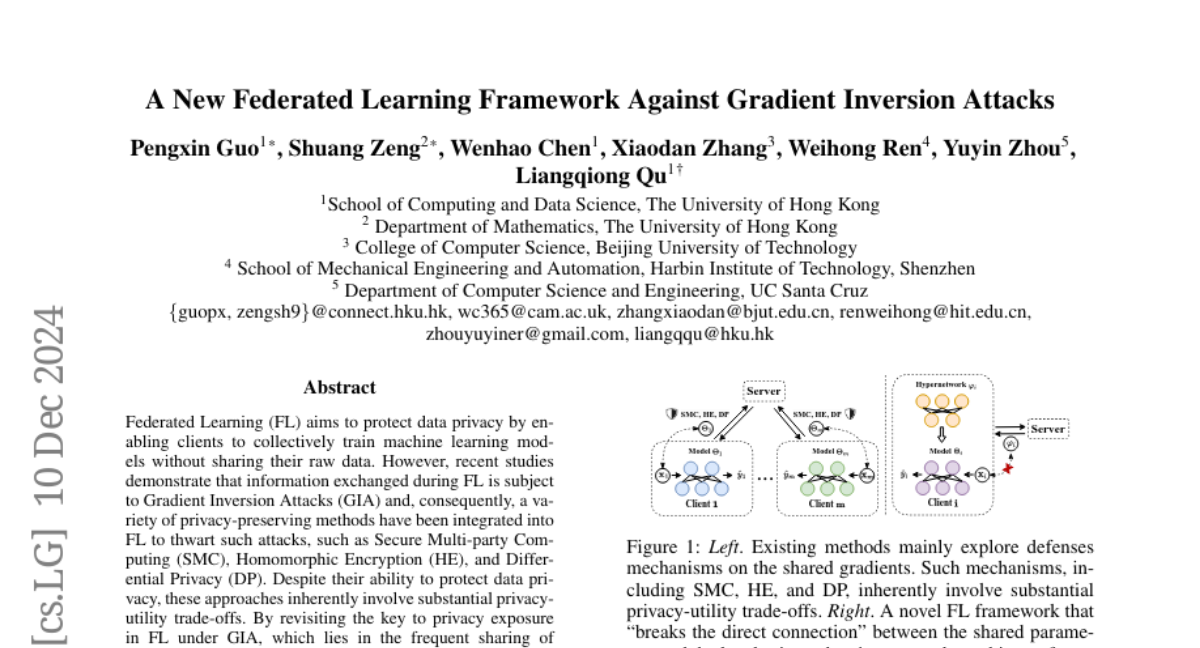

Атаки инверсии градиентов используют информацию, содержащуюся в градиентах, для восстановления данных, что ставит под угрозу конфиденциальность клиентов. В ответ на это были предложены различные методы защиты, такие как безопасные многопартнёрские вычисления (SMC), гомоморфное шифрование (HE) и дифференциальная приватность (DP). Однако эти методы часто приводят к компромиссу между конфиденциальностью и полезностью. В данной статье мы представляем новый фреймворк федеративного обучения, названный HyperFL, который использует гиперсети для генерации параметров локальных моделей и минимизирует риск утечек конфиденциальной информации.

Основные понятия

Федеративное обучение (FL)

FL позволяет нескольким клиентам совместно обучать модели, не передавая свои данные на сервер. Вместо этого клиенты обмениваются только параметрами модели, что снижает риск утечек данных. Однако обмен градиентами может раскрыть информацию о локальных данных клиентов, что делает FL уязвимым к GIA.

Атаки инверсии градиентов (GIA)

GIA представляют собой метод, с помощью которого злоумышленник может восстановить частные данные, используя градиенты, полученные от модели. Эти атаки могут быть особенно эффективными, если злоумышленник имеет доступ к градиентам, которые содержат информацию о частных данных.

Гиперсети

Гиперсети — это класс нейронных сетей, которые генерируют параметры для других сетей. Они могут использоваться для создания адаптивных и персонализированных моделей, что делает их полезными в контексте FL.

Проблема и решение

Проблема утечки конфиденциальной информации

Основная проблема, с которой сталкивается FL, заключается в том, что градиенты, которые клиенты отправляют на сервер, могут содержать информацию о локальных данных. Это создает уязвимость перед GIA, так как злоумышленник может использовать эти градиенты для восстановления частных данных.

Новый подход: HyperFL

Мы предлагаем новый фреймворк HyperFL, который "разрывает прямую связь" между параметрами, которые обмениваются клиентами, и их локальными данными. Вместо того чтобы делиться градиентами, клиенты делятся параметрами гиперсети, которые генерируют параметры локальной модели. Это позволяет сохранить конфиденциальность данных, минимизируя риск утечек.

Архитектура HyperFL

Основная конфигурация

В основной конфигурации HyperFL каждый клиент имеет классификационную сеть, параметризованную с помощью гиперсети. Гиперсеть генерирует параметры для извлекателя признаков, которые затем используются для классификации. Клиенты отправляют только параметры гиперсети на сервер, что значительно снижает риск утечек данных.

HyperFL для больших предобученных моделей

Для сложных задач, где используются большие предобученные модели, HyperFL может адаптироваться, используя фиксированные извлекатели признаков и генерируя параметры адаптеров через гиперсеть. Это позволяет эффективно использовать мощные модели, такие как ResNet и ViT, без необходимости передавать все параметры на сервер.

Анализ конфиденциальности

Защита конфиденциальности

HyperFL предлагает значительное улучшение в защите конфиденциальности по сравнению с традиционными методами. Поскольку клиенты обмениваются только параметрами гиперсети, злоумышленнику становится значительно сложнее восстановить локальные данные. Мы провели теоретический анализ, который подтверждает, что HyperFL эффективно защищает данные клиентов от GIA.

Конвергенция

Мы также провели анализ сходимости HyperFL. Результаты показали, что HyperFL достигает аналогичной скорости сходимости по сравнению с FedAvg, что делает его подходящим для практического применения.

Экспериментальные результаты

Мы провели серию экспериментов, чтобы оценить производительность HyperFL на различных наборах данных, включая EMNIST, Fashion-MNIST, CIFAR-10 и CINIC-10. Результаты показали, что HyperFL превосходит традиционные методы, такие как FedAvg и DP-методы, как по точности, так и по скорости обучения.

Оценка конфиденциальности

Кроме того, мы оценили защиту конфиденциальности HyperFL с помощью различных методов атаки, включая IG и ROG. Результаты показали, что HyperFL обеспечивает высокий уровень защиты конфиденциальности, сохраняя при этом производительность модели.

Заключение

В этой статье мы представили HyperFL — новый фреймворк федеративного обучения, который эффективно защищает конфиденциальность данных клиентов от атак инверсии градиентов. Используя гиперсети для генерации параметров локальных моделей, HyperFL минимизирует риск утечек данных и достигает высокой производительности. Мы надеемся, что этот подход вдохновит дальнейшие исследования в области защиты конфиденциальности в федеративном обучении и приведет к разработке новых методов, которые обеспечивают более высокий уровень безопасности при сохранении полезности моделей.