Генерация видео с сохранением идентичности на основе текста: концепция ConsisID

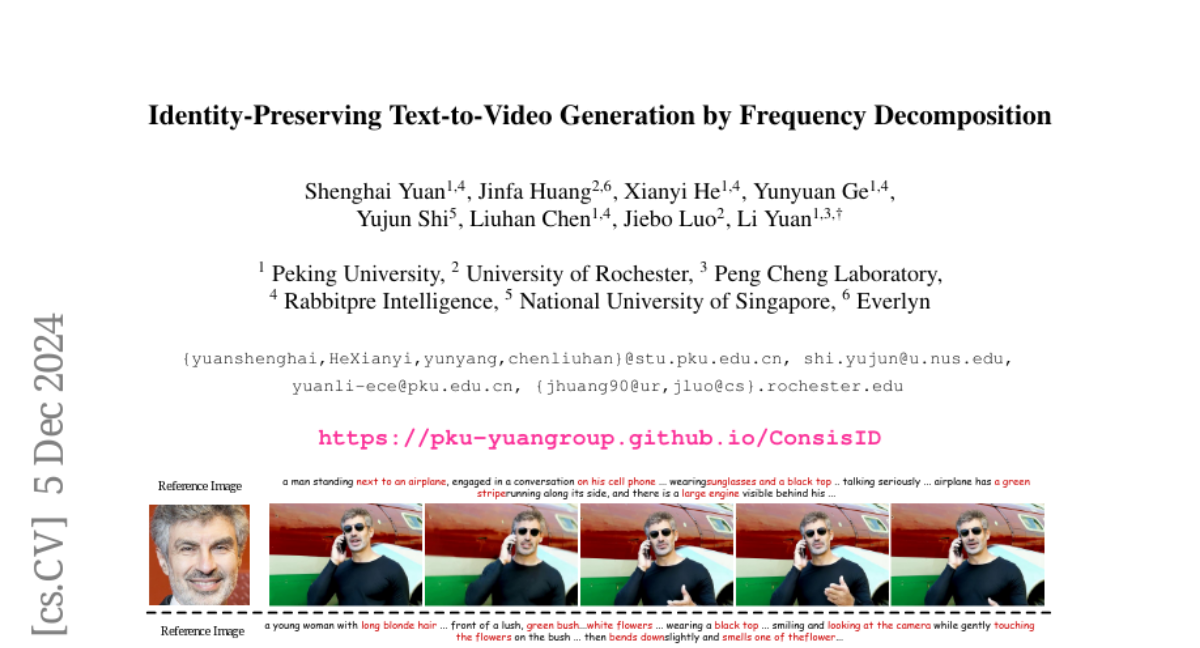

С появлением мощных моделей генерации видео, таких как модели диффузии, исследователи начали разрабатывать методы, позволяющие создавать высококачественные видео с сохранением идентичности персонажа на основе текстовых описаний. Однако, несмотря на достижения в данной области, многие существующие подходы требуют тонкой настройки для каждого нового персонажа, что ограничивает их практическое применение. В этой статье мы рассмотрим новый подход, представленный в работе "Identity-Preserving Text-to-Video Generation by Frequency Decomposition", который предлагает решение проблемы сохранения идентичности без необходимости в тонкой настройке.

Основные проблемы существующих методов

Современные модели генерации видео сталкиваются с несколькими основными вызовами:

-

Необходимость тонкой настройки: Модели, такие как DreamBooth, требуют индивидуальной настройки для каждого нового персонажа, что увеличивает затраты времени и ресурсов.

-

Сложности с высокочастотной информацией: Традиционные архитектуры, такие как U-Net, обладают лучшей способностью к обработке высокочастотной информации, необходимой для сохранения деталей лица. В то время как новые архитектуры, такие как Diffusion Transformers (DiT), имеют ограничения в этом аспекте.

-

Общая производительность: Существующие методы часто демонстрируют недостаточную производительность в сохранении идентичности, особенно при генерации видео с высокими требованиями к качеству.

Подход ConsisID

Предложенный подход, ConsisID, представляет собой модель, основанную на диффузионных трансформерах, которая использует частотное разложение для улучшения сохранения идентичности в сгенерированных видео. Основные компоненты подхода включают:

-

Глобальный и локальный экстракторы лицевых признаков: Модель использует два типа экстракторов для захвата как низкочастотной, так и высокочастотной информации о лице. Глобальный экстрактор фокусируется на общих чертах лица, таких как форма и пропорции, в то время как локальный экстрактор захватывает детализированные признаки, такие как текстуры глаз и губ.

-

Стратегия иерархического обучения: ConsisID использует стратегию обучения, при которой модель сначала обучается на глобальных признаках, а затем уточняет детали на высокочастотной информации. Это позволяет эффективно сохранять идентичность на протяжении всего видео.

-

Контрольные сигналы на основе частотного анализа: Модель использует контрольные сигналы, основанные на частотном разложении, что позволяет ей лучше управлять сохранением идентичности. Это достигается путем декомпозиции признаков идентичности на высокочастотные и низкочастотные компоненты, которые затем интегрируются в модель.

Методология

1. Теоретические основы

Исходя из предыдущих исследований, авторы выделили два основных вывода касательно работы диффузионных трансформеров:

-

Низкочастотные признаки важны для обучения: Низкочастотные признаки, которые содержат общую информацию о лице, помогают модели быстрее обучаться и достигать лучшей сходимости.

-

Ограниченная чувствительность к высокочастотной информации: Трансформеры имеют недостаточную способность воспринимать высокочастотные детали, которые критически важны для сохранения уникальных черт лица.

2. Структура ConsisID

ConsisID состоит из нескольких ключевых компонентов:

-

Глобальный экстрактор лицевых признаков: Этот компонент отвечает за извлечение низкочастотной информации из изображения, что позволяет модели лучше справляться с задачами генерации.

-

Локальный экстрактор лицевых признаков: Он захватывает высокочастотные детали, которые важны для сохранения идентичности и редактирования видео.

-

Частотное разложение: Модель декомпозирует идентичностные признаки на высокочастотные и низкочастотные компоненты, что позволяет более точно управлять процессом генерации.

3. Стратегия иерархического обучения

Стратегия иерархического обучения включает два этапа:

-

Грубая настройка: На этом этапе модель обучается на низкочастотных признаках, что позволяет ей быстро схватывать общие черты идентичности.

-

Точная настройка: На следующем этапе акцент смещается на высокочастотные детали, что улучшает качество и точность сгенерированного видео.

Эксперименты

Авторы провели обширные эксперименты для оценки эффективности ConsisID по сравнению с существующими методами. Основные метрики включают:

-

Сохранение идентичности: Используются метрики FaceSim-Arc и FaceSim-Cur для оценки различий между сгенерированными и реальными лицами.

-

Качество изображения: Оценивается с помощью FID (Fréchet Inception Distance), который измеряет качество сгенерированных изображений.

-

Соответствие тексту: Используется метрика CLIPScore для оценки соответствия текстовым подсказкам.

Результаты

Результаты экспериментов показали, что ConsisID значительно превосходит существующие методы по всем ключевым метрикам. Особенно заметным было улучшение в сохранении идентичности и визуальном качестве. Модель также продемонстрировала высокую степень контролируемости, позволяя изменять выражения лиц и действия персонажей в соответствии с текстовыми подсказками.

Заключение

ConsisID представляет собой значительный шаг вперед в области генерации видео с сохранением идентичности. Используя частотное разложение и иерархическую стратегию обучения, модель достигает выдающихся результатов в создании высококачественных, персонализированных видео. Несмотря на успехи, остаются открытыми вопросы, связанные с точностью метрик и возможностью дальнейшего улучшения производительности модели. В будущем исследователи могут сосредоточиться на разработке новых метрик, лучше отражающих человеческое восприятие, и на улучшении способности модели к генерации более сложных и разнообразных видеосцен.