Тренировка без региональных подсказок для Diffusion Transformers

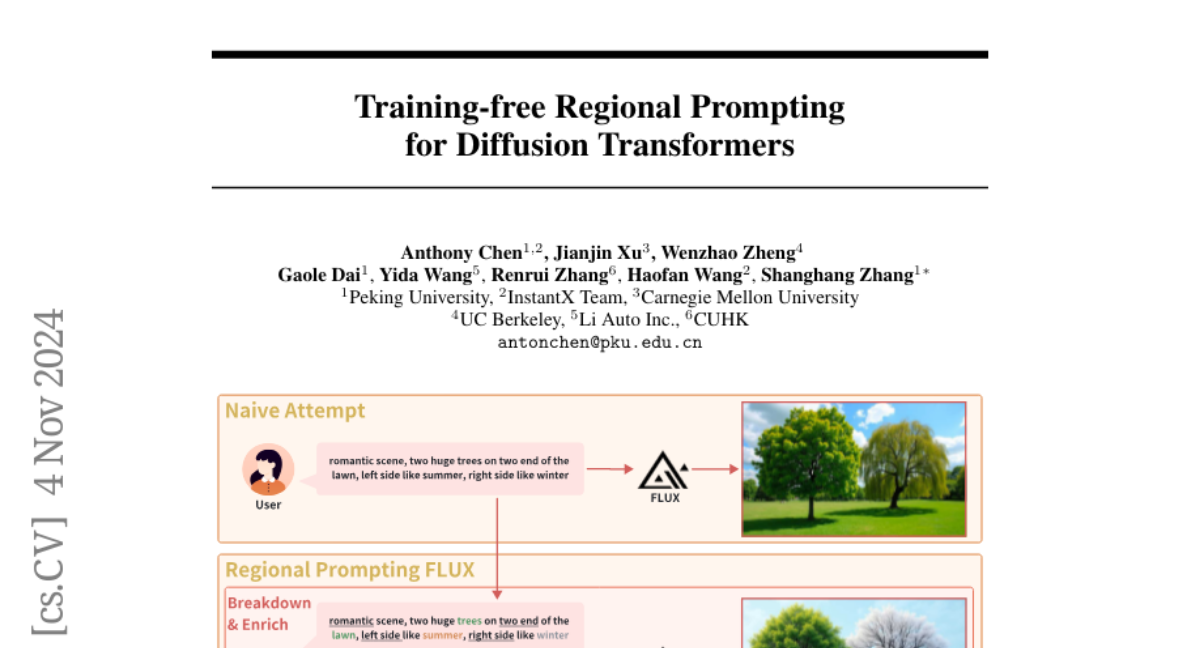

В последние годы модели генерации изображений из текста (text-to-image) значительно эволюционировали, демонстрируя выдающиеся способности в создании визуально привлекательных изображений с высокой степенью соответствия заданным текстовым описаниям. Однако, несмотря на эти достижения, модели все еще сталкиваются с вызовами при обработке сложных пространственных композиций, особенно когда текстовые подсказки включают в себя множество объектов с различными атрибутами и взаимосвязанными пространственными отношениями. В этом обзоре мы рассмотрим новый подход к решению этих проблем, предложенный в статье "Training-free Regional Prompting for Diffusion Transformers" (Anthony Chen и соавторы).

Современные модели генерации изображений из текста, такие как Stable Diffusion и FLUX, используют диффузионные модели, которые показали себя как мощные инструменты для создания высококачественных изображений. Эти модели обладают способностью следовать текстовым подсказкам благодаря интеграции с большими языковыми моделями (LLM), такими как T5 и Llama. Однако, когда дело доходит до обработки длинных и сложных текстовых подсказок, модели сталкиваются с трудностями, особенно в контексте точного размещения объектов в изображении.

Проблемы и решения

Основная проблема заключается в том, что модели не всегда могут точно интерпретировать и воплощать сложные пространственные отношения, описанные в текстовых подсказках. Это особенно актуально, когда требуется точное позиционирование объектов или когда текстовые описания включают множество элементов с различными атрибутами.

Ранние подходы к решению этой проблемы включали использование внешних условных контроллеров, таких как ControlNet, для точного управления позами и движениями объектов. Также были предприняты попытки улучшить способность модели следовать подсказкам, увеличивая размер и мощность текстовых энкодеров или используя более продвинутые языковые модели, такие как Llama 3.

Однако эти решения не всегда обеспечивают необходимую гибкость и точность в композитной генерации изображений. В статье предлагается новый метод, который позволяет модели Diffusion Transformer (DiT), такой как FLUX.1, выполнять тонкую композитную генерацию изображений без необходимости дополнительного обучения модели.

Метод: Регионально-осведомленная манипуляция вниманием

Формулировка задачи

Цель метода - улучшить способность моделей к композитной генерации, позволяя им учитывать как текстовые, так и пространственные условия без дополнительного обучения. В частности, метод фокусируется на модели FLUX.1, используя набор кортежей (c_i, m_i), где c_i - это описание подрегиона изображения, а m_i - соответствующая бинарная маска. Глобальное описание (c_base) захватывает общий семантический контент.

Реализация

Метод включает в себя создание внимательной маски M, которая модифицирует внимание в модели, чтобы объекты, описанные в c_i, генерировались внутри соответствующей области m_i. Это достигается путем:

-

Кросс-аттеншена от изображения к тексту: Региональные маски применяются, чтобы только токены изображения в каждом регионе обращали внимание на соответствующий текст.

-

Кросс-аттеншена от текста к изображению: Контролируется, чтобы каждый текстовый запрос обращал внимание только на свой регион в изображении.

-

Само-аттеншена между текстами: Каждый текстовый запрос может обращать внимание только на себя, чтобы избежать утечки подсказок.

-

Само-аттеншена внутри изображения: Внимание разрешается только внутри каждого региона, поддерживая целостность информации.

Этот подход обеспечивает, что каждая пара регион-текст учитывается в механизме внимания, сохраняя при этом целостность полного изображения и предотвращая нежелательные взаимодействия между несвязанными регионами и подсказками.

Улучшение общего качества изображения

Для улучшения общей гармонии изображений и обеспечения плавного перехода между различными регионами, метод также обновляет базовый латентный вектор, используя глобальное описание (c_base) в сочетании с региональными латентными векторами. Это делается с помощью коэффициента балансировки β, который позволяет оптимизировать баланс между эстетической привлекательностью и семантическим соответствием текстовым подсказкам.

Эксперименты и результаты

Эксперименты показали, что предложенный метод позволяет модели FLUX.1 эффективно обрабатывать сложные текстовые подсказки с региональной детализацией. Метод демонстрирует высокую скорость вывода и экономию памяти GPU по сравнению с другими методами, такими как RPG, особенно при увеличении числа региональных масок.

Основные результаты

На рисунке 2 представлены основные результаты, демонстрирующие способность метода обрабатывать различные региональные маски, обеспечивая высокую точность и адаптивность в обработке визуальных подсказок.

Обобщенная способность

Метод также совместим с другими модулями, такими как LoRAs и ControlNet, что позволяет генерировать изображения с более богатыми деталями и контролировать их структуру.

Анализ адаптации

Анализ адаптации показал, что увеличение регионального выравнивания может привести к компромиссам в качестве изображения. Например, более низкий базовый коэффициент, дополнительные шаги инъекции и больше блоков инъекции улучшают соответствие региональным подсказкам, но могут вызвать резкие визуальные границы между регионами.

Ограничения

Основное ограничение метода заключается в сложности настройки факторов при увеличении числа региональных масок. С ростом числа регионов становится все сложнее достичь идеального баланса между семантическим соответствием и визуальной гармонией.

Заключение

Предложенный метод регионально-осведомленной манипуляции вниманием для FLUX.1 представляет собой значительный шаг вперед в области генерации изображений из текста, позволяя моделям эффективно обрабатывать сложные текстовые подсказки без необходимости дополнительного обучения. Это не только ускоряет процесс генерации изображений, но и улучшает их качество и соответствие заданным текстовым описаниям. Однако, как и любой новый подход, он требует дальнейшего развития и оптимизации для достижения идеального баланса между точностью и эстетикой при работе с множеством регионов.