SepLLM: Ускорение больших языковых моделей за счет сжатия сегментов в разделители

Большие языковые модели (LLM) продемонстрировали выдающиеся результаты в различных задачах обработки естественного языка. Однако их значительные размеры создают серьезные проблемы, особенно в отношении вычислительных затрат и скорости вывода, из-за их квадратичной сложности. В данной статье мы рассмотрим новую архитектуру под названием SepLLM, которая предлагает решение этих проблем, оптимизируя использование токенов-разделителей.

Проблемы больших языковых моделей

Текущие трансформеры, основанные на архитектуре, предложенной Васвани и др. в 2017 году, сталкиваются с серьезными вычислительными вызовами при масштабировании на более крупные модели и длинные контексты. Основная проблема заключается в модуле самовнимания, который имеет квадратичную сложность по отношению к количеству входных токенов. Это приводит к значительным затратам как на обучение, так и на вывод.

Направления исследований по улучшению эффективности

Исследования в области эффективных трансформеров в основном следуют двум основным направлениям:

-

Линейное внимание: Замена стандартного модуля самовнимания на альтернативы, которые достигают линейной сложности. Однако такие архитектурные изменения значительно отличаются от традиционного самовнимания, что затрудняет использование мощных предобученных моделей.

-

Оптимизация кэша KV: Устранение избыточного кэша ключей и значений (KV) для обработки более длинных входных текстов. Например, некоторые работы предлагают адаптивные механизмы, которые выборочно сохраняют важные токены на основе накопленных оценок внимания.

Однако большинство из этих методов плохо адаптируются к этапу обучения, что приводит к несоответствиям между производительностью во время обучения и вывода.

Введение в SepLLM

SepLLM представляет собой новую архитектуру трансформеров, которая использует механизм разреженного внимания, сосредотачиваясь на начальных токенах, соседних токенах и токенах-разделителях. Мы обнаружили, что токены-разделители, такие как запятые и точки, получают значительно большее внимание по сравнению с семантически значимыми токенами. Это наблюдение привело к гипотезе о том, что информация сегментов между этими токенами может быть эффективно сжата в самих токенах-разделителях без значительных потерь информации.

Основные компоненты SepLLM

-

Начальные токены: Первые несколько токенов в предложении, которые играют важную роль в определении контекста.

-

Токены-разделители: Токены, такие как запятые и точки, которые сегментируют текст и получают высокие оценки внимания.

-

Соседние токены: Токены, которые находятся рядом с текущим токеном и помогают формировать связные фразы.

Архитектурные особенности

SepLLM использует механизм разреженного внимания, который позволяет модели сосредотачиваться только на тех токенах, которые имеют значение для текущего контекста. Это позволяет значительно сократить вычислительные затраты.

Экспериментальные результаты

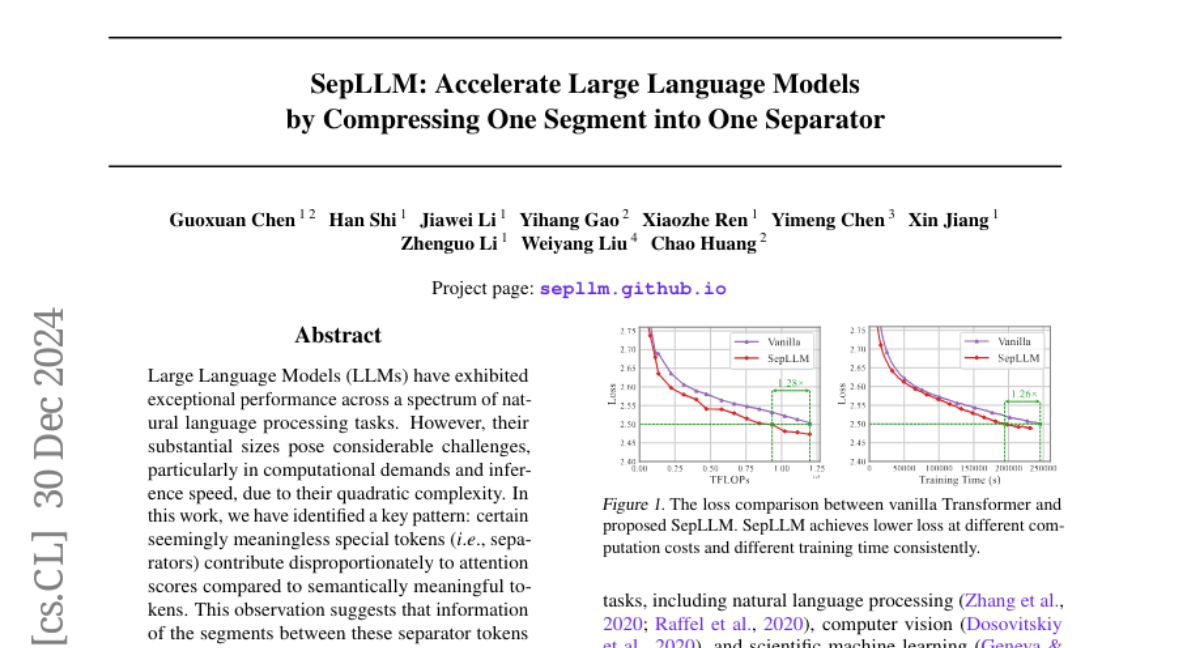

Мы провели обширные эксперименты, чтобы проверить эффективность SepLLM в различных задачах и на различных наборах данных.

Обучение без обучения

В рамках обучения без обучения мы использовали модель Llama-3-8B-Instruct и оценивали ее производительность на задачах, таких как GSM8K-CoT и MMLU. Результаты показали, что SepLLM достигает сопоставимой производительности с оригинальной моделью Llama-3, используя лишь 47,36% изначально используемых токенов KV.

Обучение с нуля

При обучении модели Pythia-160m-deduped мы наблюдали, что использование токенов-разделителей и соседних токенов значительно улучшает скорость обучения и производительность на downstream задачах. Увеличение количества соседних токенов, учитываемых моделью, приводит к более быстрому снижению потерь.

Постобучение

В рамках постобучения мы использовали 93 000 шагов модели Pythia-1.4B-deduped и провели эксперименты, чтобы оценить производительность модели SepLLM. Результаты показали, что увеличение числа токенов-разделителей улучшает производительность модели.

Приложения для потоковой передачи

SepLLM также хорошо адаптируется к потоковым приложениям, где могут происходить бесконечные взаимодействия. Мы протестировали модель на наборе данных PG19 и обнаружили, что SepLLM сохраняет более низкую перплексию при предсказании следующего токена по сравнению с другими моделями.

Заключение

SepLLM представляет собой значительный шаг вперед в области оптимизации больших языковых моделей. Используя токены-разделители для сжатия информации, мы достигли значительного ускорения вывода и уменьшения вычислительных затрат. Наша архитектура не только эффективна, но и может быть интегрирована в существующие процессы обучения, что делает ее универсальным инструментом для работы с LLM.