Evalica: Надежные и Быстрые Лидирующие Таблицы для Оценки Моделей NLP

С быстрым развитием технологий обработки естественного языка (NLP), таких как крупные языковые модели (LLMs), возникает необходимость в современных протоколах оценки, которые учитывают как человеческую, так и машинную обратную связь. В этой статье мы рассмотрим Evalica — открытый инструмент, который упрощает создание надежных и воспроизводимых лидирующих таблиц для моделей NLP. Мы обсудим его дизайн, производительность и удобство использования через различные интерфейсы, включая веб-интерфейс, командную строку и API на Python.

Проблематика оценки моделей NLP

Современные методы NLP требуют актуальных бенчмарков, которые могут обеспечивать живую обратную связь от пользователей и машин. Ранее существовавшие методы оценки можно было разумно реализовать на статических наборах данных или отдельных бенчмарках. Однако с развитием LLMs и их сложных возможностей, такие методы становятся недостаточными. Они часто реализуются в вычислительных блокнотах и ad-hoc программах, что приводит к ошибкам и несовместимостям, ухудшающим воспроизводимость и применение.

Лидирующие таблицы и их значение

Лидирующие таблицы, представленные в виде парных сравнений, стали популярными благодаря проектам, таким как LMSYS Arena и AlpacaEval. Эти таблицы позволяют сравнивать модели по их производительности, однако создание таких таблиц требует значительных усилий и может быть подвержено ошибкам. Evalica решает эту проблему, предлагая инструменты для упрощения процесса создания и управления лидирующими таблицами.

Цели и задачи Evalica

Evalica была разработана с тремя основными целями:

- Доступность популярных практик оценки: Сделать их доступными для широкой аудитории.

- Обеспечение производительности и корректности: Гарантировать, что предлагаемые реализации работают эффективно и правильно.

- Улучшение опыта разработчиков: Предоставить разработчикам удобные и интуитивно понятные инструменты.

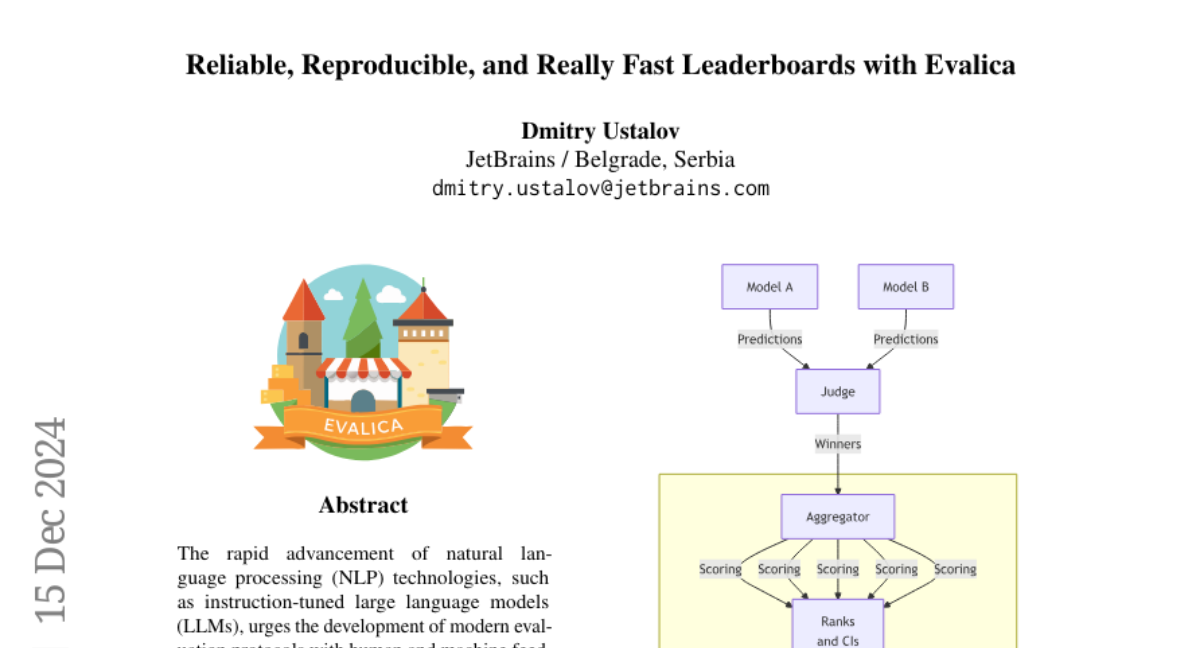

Архитектура и дизайн Evalica

Evalica состоит из нескольких компонентов, которые позволяют выполнять три основные задачи:

- Оптимизированные однопоточные реализации систем ранжирования.

- Упрощение вычисления доверительных интервалов для оценок моделей.

- Удобные процедуры для подготовки визуализаций.

Основные компоненты

В ядре Evalica находятся производительные рутинные операции, написанные на Rust, которые обрабатывают сырые данные. Эти рутинные операции обернуты в удобные API для разработчиков на других языках. Все методы были реализованы также на Python, что позволяет обеспечить надежность и простоту прототипирования.

Реализация и технические детали

Evalica реализует подходы к оценке, основанные на популярных бенчмарках, таких как Chatbot Arena и Arena-Hard. В пакет входят реализации различных методов, таких как Elo и метод Бредли-Терри. Все методы доступны через легковесный и унифицированный функциональный API.

Корректность и надежность

Для обеспечения корректности и надежности методов в Evalica были применены несколько подходов:

- Реализация всех методов независимо на двух языках программирования — Rust и Python.

- Использование тестов на основе свойств для проверки крайних случаев.

- Сравнение результатов с каноническими оценками из внешних бенчмарков.

- Обеспечение тестового покрытия не менее 100%.

Интерфейсы Evalica

Evalica предлагает несколько интерфейсов для взаимодействия с пользователями:

- Веб-интерфейс: Позволяет пользователям легко загружать данные и получать результаты.

- Командная строка: Удобен для автоматизации процессов и интеграции в рабочие потоки.

- API на Python: Предоставляет возможность разработчикам интегрировать Evalica в свои приложения.

Производительность Evalica

Мы провели несколько серий вычислительных экспериментов для изучения времени выполнения алгоритмов в Evalica. В частности, мы сравнили производительность текущих реализаций с теми, которые предоставляются Evalica.

Эксперименты на наборе данных Chatbot Arena

В одном из экспериментов мы оценили производительность различных реализаций на наборе данных Chatbot Arena, который содержит 1,7 миллиона парных сравнений между 129 моделями. Результаты показали, что реализации Evalica значительно превосходят существующие алгоритмы по времени выполнения, достигая увеличения производительности до 46 раз.

Сравнение Rust и Python в Evalica

Мы также оценили производительность методов, реализованных в Evalica на Rust, по сравнению с их наивными реализациями на Python. Результаты показали, что Rust-реализации обеспечивают значительно более высокую производительность и меньшую вариабельность времени выполнения.

Масштабируемость

Evalica была протестирована на различных размерах наборов данных, чтобы оценить масштабируемость. Результаты показали линейную зависимость между размером набора данных и временем вычислений, что указывает на хорошую масштабируемость всех методов.

Заключение

Evalica представляет собой мощный инструмент для создания надежных и воспроизводимых бенчмарков для систем NLP. Она предлагает уникальные возможности для ускорения процессов оценки и улучшения качества моделей. Мы надеемся на дальнейшее развитие Evalica, включая реализацию большего количества алгоритмов, оптимизацию производительности и поддержку других языков программирования.

Evalica уже сейчас может значительно сократить время на итерации и улучшить качество экспериментов в области NLP, что делает её важным инструментом для исследователей и разработчиков.