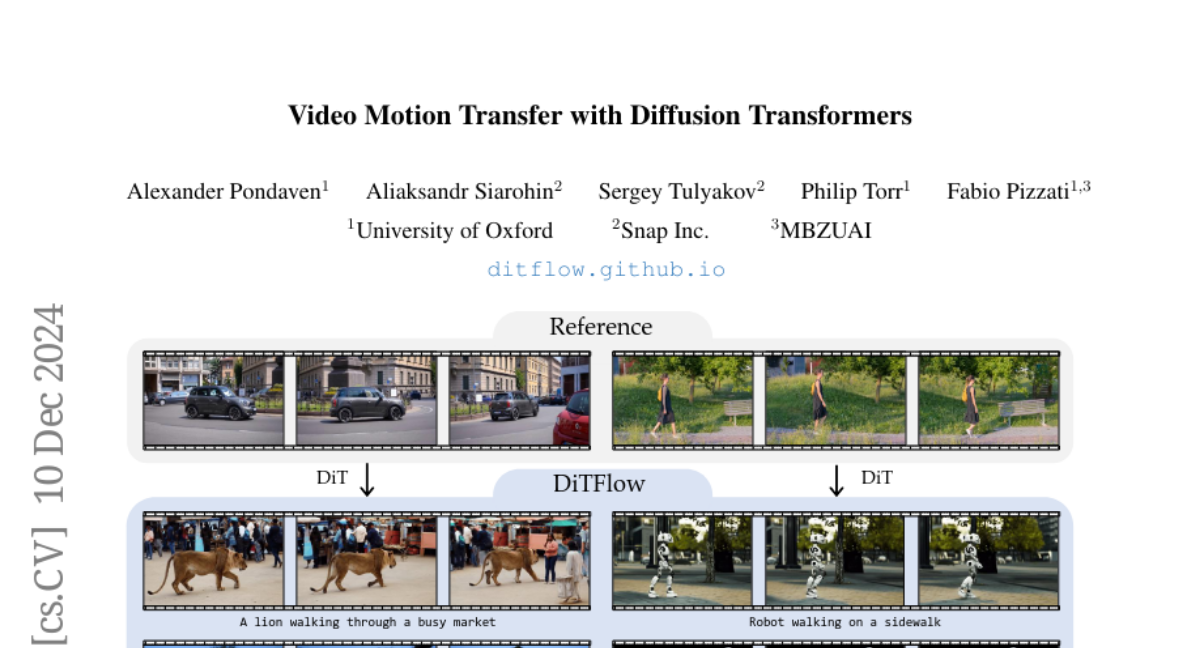

Перенос движения в видео с помощью диффузионных трансформеров

В последние годы модели диффузии стали стандартом для синтеза визуального контента, особенно в видео. В данной статье мы обсудим метод DiTFlow, который предлагает новый подход к переносу движения из одного видео в другое, используя диффузионные трансформеры (DiT). Это решение позволяет синтезировать новые видео с заданными движениями, что открывает новые горизонты в области видео-редактирования и создания контента.

Синтез видео требует значительных вычислительных ресурсов и объемных наборов данных для достижения реалистичного результата. Модели диффузии, такие как DiT, предлагают улучшенную масштабируемость и качество, что делает их идеальными для задач синтеза видео. Однако, для успешного применения этих моделей необходимо обеспечить контроль над генерируемым контентом, особенно в отношении движения объектов в сцене.

Проблема контроля движения

Современные подходы к синтезу видео часто полагаются на текстовые подсказки для управления генерацией. Однако текстовые описания не всегда могут точно передать, как объекты должны двигаться в сцене. Это приводит к необходимости разработки методов переноса движения, которые могут использовать существующие видео как ориентиры для создания новых сцен с реалистичным движением.

Концепция DiTFlow

DiTFlow — это метод, который использует диффузионные трансформеры для переноса движения из одного видео в другое. Он работает, извлекая информацию о движении из видео-референса и применяя ее к новым видео-синтезам. Основные компоненты DiTFlow включают:

- Извлечение Attention Motion Flow (AMF): Мы используем предобученную модель DiT для анализа видеореференса и извлечения информации о движении.

- Оптимизация латентного пространства: Вместо традиционного обучения, DiTFlow использует оптимизацию для переноса движения, что позволяет достичь результатов без необходимости повторного обучения модели.

- Поддержка нулевого выстрела: Оптимизация позиционных встраиваний позволяет передавать изученные движения на новые генерации без дополнительной оптимизации.

Связанные работы

Существует множество методов, которые исследуют текстово-видео (T2V) подходы. Многие из них основаны на архитектуре UNet и используют отдельные модули временного внимания. Однако, DiT, с его способностью обрабатывать пространственно-временную информацию через механизмы внимания, предлагает более эффективные решения для извлечения информации о движении.

Подходы к переносу движения

Существующие методы переноса движения могут быть разделены на две категории: те, которые требуют обучения, и те, которые используют оптимизацию на этапе вывода. DiTFlow относится ко второй категории и предлагает более гибкий способ извлечения и передачи движений.

Основные понятия

Модели T2V

Модели T2V используют диффузионные механизмы, чтобы преобразовать шумовые латенты в конечное видео. Эти модели обычно работают в латентном пространстве, что позволяет значительно снизить вычислительные затраты.

Диффузионные трансформеры

В отличие от UNet, диффузионные трансформеры обрабатывают шумные латенты как последовательность токенов. Это позволяет им эффективно захватывать долгосрочные зависимости и улучшать качество синтезируемого видео.

Методология DiTFlow

Извлечение AMF

Основная идея DiTFlow заключается в извлечении информации о движении через анализ внимания между кадрами. Мы используем механизм внимания для вычисления зависимостей между токенами, представляющими различные кадры. Это позволяет нам получить матрицы смещения, которые указывают, как каждый элемент в кадре будет перемещаться во времени.

Оптимизация и передача движения

После извлечения AMF, мы используем его для управления процессом денойзинга. В процессе оптимизации мы минимизируем расстояние между извлеченной AMF и текущей AMF, что позволяет генерировать новые видео с заданными движениями.

Поддержка нулевого выстрела

Одним из значительных преимуществ DiTFlow является возможность передачи движения без необходимости повторной оптимизации. Это достигается за счет оптимизации позиционных встраиваний, что позволяет нам использовать ранее изученные движения для новых генераций.

Эксперименты

Настройка экспериментов

Для оценки DiTFlow мы использовали 50 уникальных видео из набора данных DAVIS. Мы тестировали каждое видео с тремя различными подсказками, чтобы оценить качество переноса движения.

Количественная оценка

Результаты показали, что DiTFlow значительно превосходит существующие методы, такие как SMM и MOFT, по всем метрикам. Мы наблюдали улучшение как в метриках качества изображения (IQ), так и в метриках точности движения (MF).

Качественная оценка

Качественные результаты также подтвердили эффективность DiTFlow. Мы провели оценку с участием людей, которые оценивали качество синтезируемых видео на основе их соответствия движению и текстовым подсказкам.

Заключение

DiTFlow представляет собой значительный шаг вперед в области переноса движения в видео. Используя диффузионные трансформеры и уникальные методы извлечения информации о движении, DiTFlow позволяет создавать новые видео с реалистичным движением, что открывает новые возможности для видео-редактирования и создания контента. Этот метод может значительно снизить затраты на генерацию видео и улучшить контроль над движением объектов в сценах.

DiTFlow демонстрирует, что с помощью современных архитектур, таких как диффузионные трансформеры, можно решать сложные задачи, которые ранее считались трудными или невозможными. В будущем мы ожидаем дальнейших улучшений и расширений возможностей DiTFlow, что может привести к новым применениям в области искусственного интеллекта и генеративного моделирования.