Контекстуализированная контрречь: стратегии адаптации, персонализации и оценки

Онлайн-токсичность, включая ненавистные, оскорбительные и иные вредные высказывания, представляет собой серьезную проблему в цифровом пространстве. Эти виды речи могут вызывать беспокойство у читателей и приводить к отказу от участия в обсуждениях. Социальные платформы применяют различные меры модерации, включая удаление контента и пользователей, а также вмешательства, направленные на снижение токсичности. В качестве альтернативы централизованной модерации возникает концепция социальной коррекции, известной как контрречь, где пользователи активно реагируют на токсичный контент, способствуя уважительному и конструктивному общению.

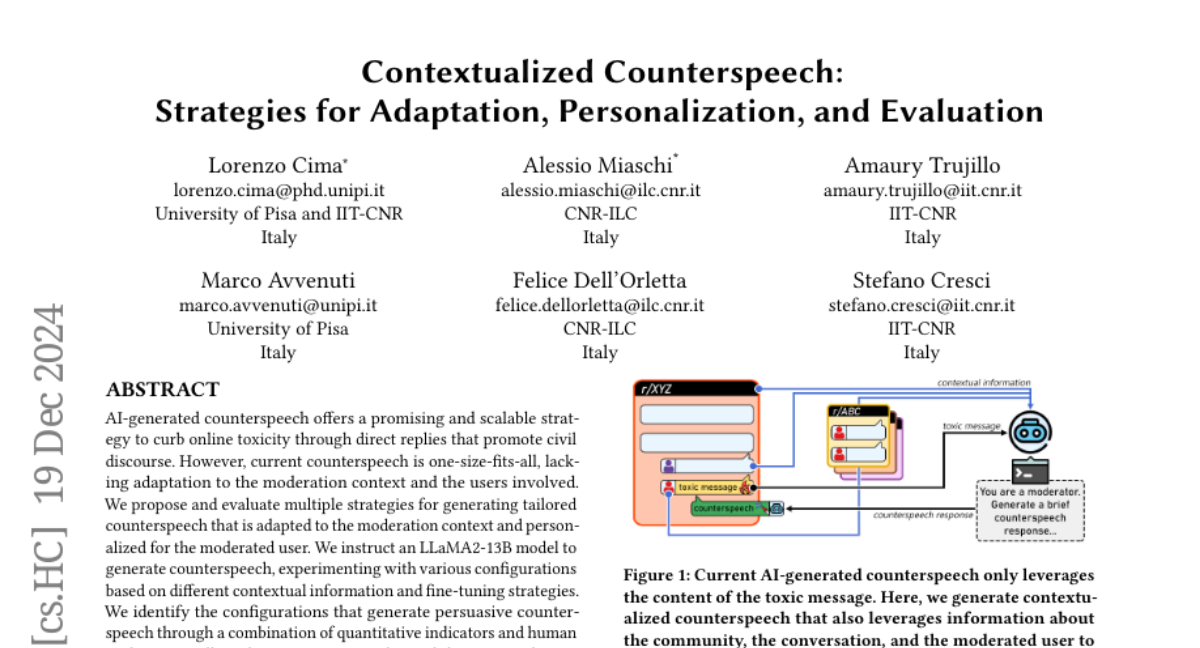

Однако, несмотря на обнадеживающие результаты, контрречь сталкивается с рядом проблем, включая эмоциональное бремя на ответчиков и угрозу мести. В связи с этим автоматизированные системы контрречи, использующие генеративные технологии ИИ, такие как большие языковые модели (LLM), становятся все более актуальными. Тем не менее, текущие системы контрречи часто применяют универсальный подход, который не учитывает контекст модерации и особенности пользователей.

В данной статье мы рассматриваем использование LLM для генерации адаптированной и персонализированной контрречи, которая учитывает контекст модерации и характеристики пользователя. Мы исследуем различные стратегии адаптации и персонализации, а также оцениваем их эффективность.

Проблема определения

Для генерации контрречи мы рассматриваем онлайн-обсуждение как последовательность сообщений, где каждое сообщение может содержать токсичный контент. Наша цель заключается в создании контрречи, которая будет учитывать контекст, в котором она генерируется. Это означает, что контрречь должна не только реагировать на токсичное сообщение, но и учитывать предшествующие сообщения в обсуждении, а также характеристики пользователя, который его опубликовал.

Желаемые характеристики контрречи

Эффективная контрречь должна обладать следующими свойствами:

- Вежливость: Увеличивает вероятность убеждения токсичных пользователей и наблюдателей, способствуя уважительному диалогу.

- Адекватность: Ответ должен непосредственно адресовать токсичное содержание, показывая, что нарушение было замечено и соответствующим образом обработано.

- Релевантность: Сообщения, которые имеют контекстуальную значимость, более вероятно вызовут отклик у получателей.

- Разнообразие: Разнообразные сообщения могут по-разному вовлекать пользователей, предотвращая предсказуемость и увеличивая воспринимаемую аутентичность.

- Правдивость: Контрречь должна быть фактической и точной, чтобы поддерживать доверие и авторитет.

- Убедительность: Способность изменять поведение или установки модератора, а также влиять на наблюдателей.

Дополнительно, контекстуализированная контрречь должна учитывать:

- Адаптацию: Ответы должны быть релевантными для контекста, чтобы восприниматься как искренние и продуманные.

- Персонализацию: Учитывать характеристики и поведение конкретного пользователя, чтобы строить доверительные отношения и снижать защитные реакции.

Методы

Генерация контрречи

Для генерации контрречи мы используем модель LLaMA2-13B, настроенную на создание ответов на токсичные сообщения. Мы исследуем различные конфигурации, основанные на информации, предоставленной модели, и данных, используемых для дообучения.

Факторы генерации

Некоторые факторы, которые мы рассматриваем, включают:

- Базовая модель: Исходная модель LLaMA2-13B без модификаций.

- Дообучение на контрречи: Специализация модели для генерации контрречи на основе существующих наборов данных, таких как MultiCONAN и Reddit Hate Speech Intervention.

- Адаптация: Учет сообщества и стиля общения на Reddit.

- Персонализация: Использование истории комментариев пользователя и резюме, чтобы создать более персонализированные ответы.

Оценка

Оценка контрречи включает как алгоритмические, так и человеческие методы. Мы используем набор количественных индикаторов для автоматической оценки свойств сгенерированных сообщений, а затем проводим ручную оценку для выбора наиболее эффективных конфигураций.

Алгоритмическая оценка

Мы применяем несколько индикаторов, таких как:

- Релевантность: Оценка соответствия контрречи токсичному сообщению.

- Разнообразие: Измерение разнообразия сгенерированных сообщений.

- Читаемость: Оценка легкости восприятия текста.

- Токсичность: Использование API для оценки уровня токсичности сгенерированных ответов.

Человеческая оценка

Мы проводим краудсорсинг-эксперимент, в котором участники оценивают пары токсичных сообщений и контрречи по различным критериям, включая релевантность, адекватность и убедительность.

Результаты

Алгоритмическая оценка

Результаты алгоритмической оценки показывают, что использование адаптации и персонализации значительно улучшает характеристики контрречи. Например, модели, которые учитывают контекст обсуждения и историю пользователя, продемонстрировали более высокие результаты по релевантности и адекватности.

Человеческая оценка

Результаты человеческой оценки подтвердили, что контекстуализированная контрречь, сгенерированная с учетом адаптации и персонализации, воспринимается как более убедительная и релевантная. Участники оценивали контрречь, основанную на контексте, значительно выше, чем универсальные ответы.

Обсуждение и выводы

Наше исследование подчеркивает важность контекстуализированной контрречи в борьбе с онлайн-токсичностью. Генерация ответов, учитывающих как контекст, так и индивидуальные характеристики пользователей, значительно повышает их эффективность. Однако существует необходимость в более тонком оценивании, так как алгоритмические индикаторы часто не совпадают с человеческими оценками.

Ограничения и будущее исследования

Несмотря на обширные эксперименты, наше исследование ограничено использованием одной модели LLM и ограниченным набором стратегий адаптации и персонализации. Будущие исследования должны сосредоточиться на разработке более сложных моделей и методик, чтобы обеспечить справедливость и беспристрастность AI-сгенерированных ответов.

В заключение, наше исследование указывает на необходимость увеличения сотрудничества между людьми и AI для повышения эффективности модерации контента в онлайн-пространстве.