Погружение в документы: Последствия масштабирования вывода переоценщиков

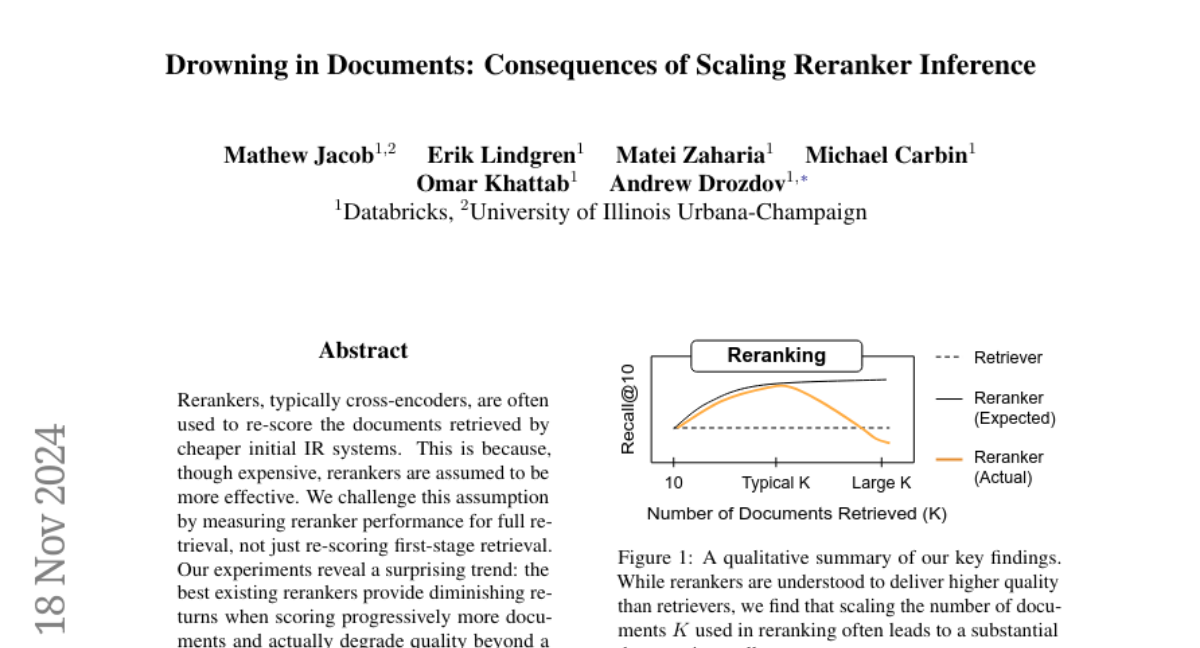

В современных системах информационного поиска (IR) переоценщики (обычно кросс-энкодеры) часто используются для повторной оценки документов, полученных более дешёвыми начальными системами поиска. Предполагается, что переоценщики, несмотря на свою вычислительную дороговизну, обеспечивают более высокую эффективность. Однако, в данной статье мы бросаем вызов этому предположению, анализируя производительность переоценщиков не только в контексте повторной оценки, но и в полноценном поиске.

Основные понятия

Переоценщики (Rerankers)

Переоценщики — это модели, которые оценивают релевантность документов к запросу более детально, чем первоначальные системы поиска. Они обычно используют архитектуру кросс-энкодеров, где запрос и документ кодируются совместно, позволяя модели учитывать взаимодействия между ними.

Первичные системы поиска (Retrievers)

Первичные системы поиска предварительно вычисляют представления документов, чтобы быстро находить потенциально релевантные документы для запроса. Эти системы могут быть как лексическими (например, BM25), так и плотными (например, использующие трансформеры для создания векторных представлений).

Торговля между качеством и стоимостью

Современные IR системы часто используют многоэтапные пайплайны переоценки, где быстрый ретривер находит первоначальные кандидаты, а затем переоценщик оценивает только эти кандидаты. Это позволяет балансировать между качеством поиска и вычислительными затратами.

Экспериментальные результаты

Масштабирование переоценки

Мы провели эксперименты, где переоценщики оценивали прогрессивно большее количество документов (K). Результаты показали:

- Переоценщики эффективны на малых значениях K: На малом числе документов (например, до 100) переоценщики улучшают качество поиска.

- Ухудшение качества при увеличении K: По мере увеличения числа документов для переоценки, качество поиска начинает ухудшаться. Это противоречит ожиданиям, что больше документов для переоценки приведет к лучшему результату.

Полное извлечение (Full Retrieval)

Когда переоценщики использовались для ранжирования всего корпуса документов, они часто показали результаты хуже, чем первичные системы поиска. Это вызывает вопрос о том, насколько эффективны переоценщики в реальных сценариях, когда они не ограничены небольшим числом документов для оценки.

Анализ ошибок

Анализ показал, что переоценщики иногда присваивают высокие оценки документам, которые не имеют лексического или семантического перекрытия с запросом, что может привести к неожиданным ошибкам в ранжировании.

Проблемы и перспективы

Недостаточное обучение на негативах

Одной из возможных причин снижения эффективности переоценщиков при большом числе документов может быть их обучение на ограниченном наборе негативных примеров. Это приводит к тому, что модели не справляются с большим количеством разнообразных негативных примеров в реальных условиях.

Переоценка как ансамбль

Возможно, что переоценщики работают лучше всего в качестве ансамбля, где они дополняют первичные системы поиска, предоставляя альтернативные признаки для ранжирования.

Робастность глубокого обучения

Глубокое обучение моделей показывает, что они не всегда устойчивы к масштабированию, особенно когда речь идет о ранжировании большого числа документов.

Списоковое ранжирование с использованием LLM

В качестве альтернативы точечному ранжированию (pointwise ranking) с использованием кросс-энкодеров, мы исследовали списоковое ранжирование (listwise ranking) с помощью больших языковых моделей (LLM). Такой подход показал более высокую устойчивость к масштабированию и лучшее качество ранжирования.

Заключение

Наше исследование выявило, что современные переоценщики не всегда соответствуют ожиданиям в реальных условиях масштабирования. Это открывает путь для дальнейших исследований в области улучшения переоценщиков, особенно в направлении их устойчивости к шуму и способности к эффективному ранжированию большого числа документов. Использование LLM для списокового ранжирования представляет собой перспективное направление для будущих разработок в этой области.