Поиск, проверка и обратная связь: К следующему поколению пост-тренировочного парадигма фундаментальных моделей через инженерию верификаторов

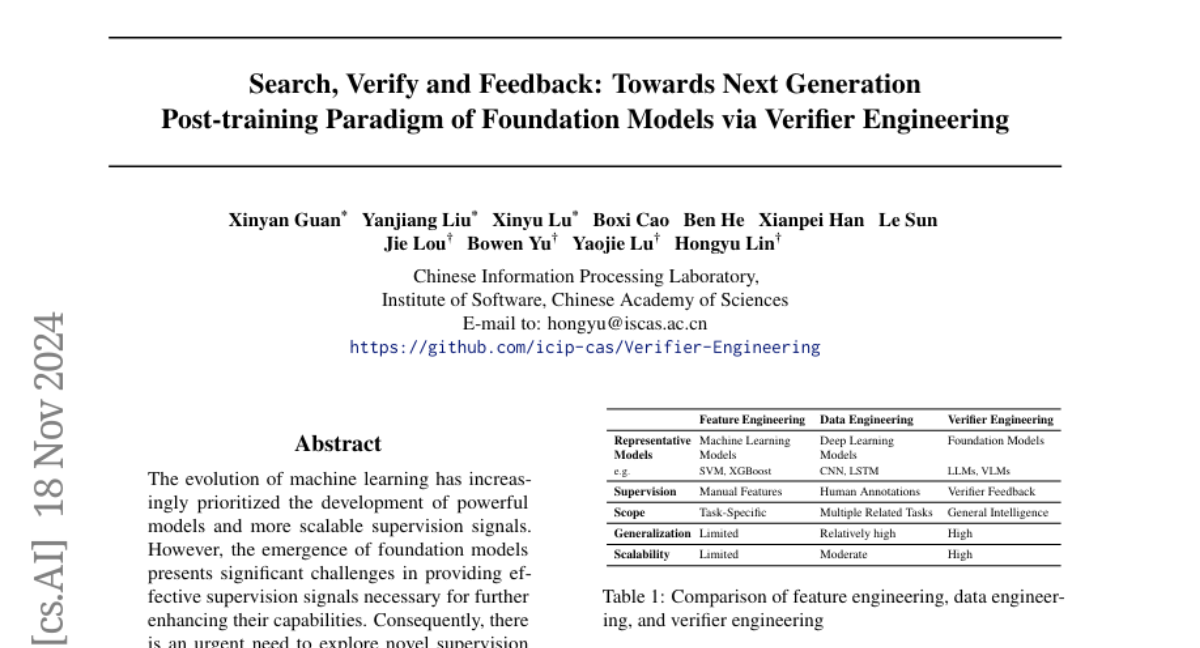

Эволюция машинного обучения (ML) характеризуется стремлением к созданию всё более мощных моделей и увеличению масштабности сигналов надзора. В последние годы появление фундаментальных моделей (foundation models) представило новые вызовы в предоставлении эффективных сигналов надзора, необходимых для дальнейшего улучшения их возможностей. Эти модели, такие как большие языковые модели (LLMs), демонстрируют исключительные способности, но традиционные подходы к инженерии данных и функций достигли своих практических пределов. В этой статье мы представляем новый подход, названный инженерией верификаторов (verifier engineering), который предназначен для решения этих проблем.

Эволюция машинного обучения

Машинное обучение прошло через несколько ключевых этапов:

- Инженерия признаков (Feature Engineering): В начале, когда модели имели ограниченную емкость, эксперты вручную проектировали и извлекали релевантные признаки. Алгоритмы, такие как SVM и Decision Trees, полагались на тщательно разработанные признаки для достижения оптимальной производительности.

- Инженерия данных (Data Engineering): С появлением глубокого обучения (deep learning) акцент сместился на создание качественных наборов данных и аннотаций. Проекты, такие как ImageNet и BERT, продемонстрировали эффективность этого подхода.

- Инженерия верификаторов (Verifier Engineering): Сейчас, когда фундаментальные модели стали доминировать, традиционные методы инженерии данных сталкиваются с трудностями из-за высоких затрат на качественные аннотации и сложности в предоставлении значимых руководств для дальнейшего улучшения моделей.

Основные понятия инженерии верификаторов

Инженерия верификаторов расширяет создание сигналов надзора за пределы ручного извлечения признаков и аннотации данных. Вместо этого, она использует набор эффективных автоматизированных верификаторов для выполнения задач верификации и предоставления значимой обратной связи фундаментальным моделям.

Три основных этапа:

-

Поиск (Search): Генерация представительных или потенциально проблематичных выборок из распределения выходов модели для выявления границ производительности и ограничений.

-

Проверка (Verify): Использование различных верификаторов для предоставления результатов верификации на основе кандидатских ответов, включая метрики оценки, обнаружение правил или выборочную ручную аннотацию.

-

Обратная связь (Feedback): Использование результатов верификации для улучшения производительности модели через методы, такие как супервизированная настройка (SFT) или обучение на контексте (In-Context Learning).

Примеры инженерии верификаторов

-

RLHF (Reinforcement Learning from Human Feedback): Использует линейный поиск для генерации пакетов ответов, применяет модель вознаграждения в качестве верификатора и оптимизирует модель на основе результатов верификации с помощью алгоритма PPO.

-

OmegaPRM: Использует процессную модель вознаграждения (PRM) в качестве верификатора и ищет лучший результат на основе PRM, максимизируя процессные оценки вознаграждения.

-

Экспериментальное совместное обучение (Experiential Co-Learning): Совместно использует несколько LLM для улучшения как верификации, так и производительности модели через исторические данные взаимодействий.

Заключение

Инженерия верификаторов представляет собой фундаментальный путь к достижению искусственного общего интеллекта (AGI). Она предлагает новый подход к улучшению фундаментальных моделей, который выходит за рамки традиционных методов, фокусируясь на автоматизированной верификации и обратной связи. В следующих разделах мы подробно рассмотрим каждый из трех этапов инженерии верификаторов, обсудим текущие тенденции и ограничения, а также предложим направления для будущих исследований.