Комплексная и практическая оценка систем RAG для медицинских вопросов

В последние годы крупные языковые модели (LLM) продемонстрировали выдающиеся способности в решении сложных медицинских задач, достигая рекордных результатов на различных бенчмарках. Однако, обеспечение надежности и достоверности таких систем остается критически важной задачей, особенно в области здравоохранения. Retrieval-augmented generation (RAG) представляет собой перспективный подход, который может уменьшить проблему галлюцинаций LLM, интегрируя внешние источники знаний. Хотя RAG имеет потенциал улучшить фактическую точность ответов LLM, внедрение системы поиска информации также вносит новые сложности, требующие тщательной оценки.

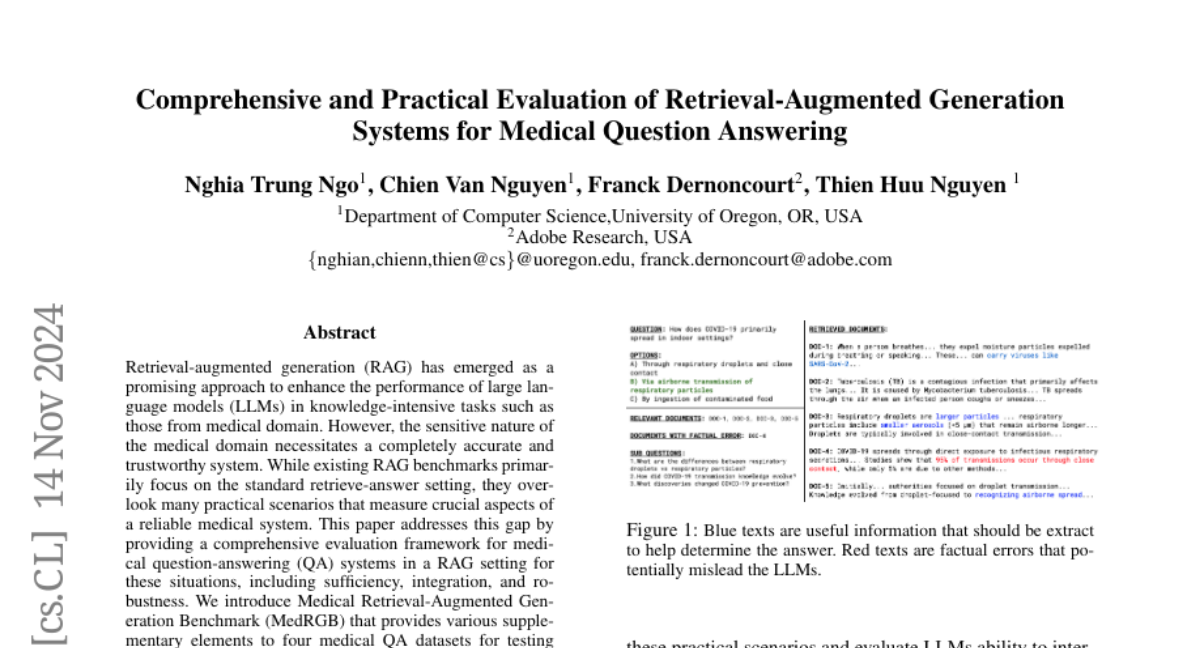

Рассмотрим пример, показанный на рисунке 1. В нем представлены документы, содержащие не только полезную информацию, которая помогает определить правильный ответ, но и шумные данные или, что еще хуже, фактические ошибки, которые могут ввести в заблуждение LLM. Для осознанного применения RAG в медицинских вопросах необходимо учитывать эти практические сценарии и оценивать способность LLM надежно взаимодействовать с извлеченными документами.

Существующие работы

Недавние усилия по оценке систем AI с использованием LLM в медицинской области включают работы таких авторов, как Nori et al. (2023) и He et al. (2023). Например, MedEval (He et al., 2023) представляет собой крупномасштабный, экспертно-аннотированный бенчмарк, охватывающий различные медицинские задачи и области. Xiong et al. (2024) проводят обширную оценку RAG на основе их бенчмарка MIRAGE, который охватывает 5 медицинских датасетов для вопросов и ответов. Однако, эти работы сосредоточены в основном на влиянии модулей RAG на целевую точность, упуская из виду другие важные аспекты медицинской системы AI.

Некоторые недавние исследования более комплексно подходят к оценке RAG в общем домене (Es et al., 2023; Chen et al., 2024b). Например, RAGAS (Es et al., 2023) оценивает три качества выходных данных RAG для задач вопросов и ответов: верность (насколько ответы соответствуют предоставленному контексту), релевантность ответа (насколько сгенерированные ответы адресуют поставленный вопрос) и точность и полноту контекста (качество извлеченного контекста). Мы следуем работе Chen et al. (2024b), которая устанавливает бенчмарк Retrieval-Augmented Generation Benchmark (RGB) для измерения четырех способностей, необходимых для RAG, включая устойчивость к шуму, отклонение от негативных примеров, интеграцию информации и устойчивость к контрафактическим примерам.

Медицинский бенчмарк RAG

В этой статье мы представляем Медицинский бенчмарк RAG (MedRGB), который предоставляет дополнительные элементы к четырем медицинским датасетам для тестирования способности LLM справляться с этими специфическими сценариями. MedRGB включает в себя:

- Стандартный тест RAG: Оценивает производительность LLM при предоставлении нескольких релевантных документов для ответа на вопрос.

- Тест на достаточность: Оценивает надежность LLM при наличии шумных документов в извлеченном контексте. Добавляя "Недостаточно информации" как дополнительный вариант ответа, LLM должны отвечать только тогда, когда они уверены в наличии достаточной информации для определения правильного ответа.

- Тест на интеграцию: Оценивает способность LLM отвечать на несколько поддерживающих вопросов и интегрировать извлеченную информацию для ответа на основной вопрос.

- Тест на устойчивость: Оценивает устойчивость LLM к фактическим ошибкам в извлеченном контексте. Надежная медицинская система AI должна быть способна обнаруживать фактически некорректные документы и предоставлять исправленную информацию.

Всего MedRGB состоит из 3480 экземпляров для четырех тестовых сценариев, что более чем в 5 раз превышает количество примеров в RGB. Используя MedRGB, мы проводим обширные оценки 7 LLM, включая как передовые коммерческие модели, так и модели с открытым исходным кодом.

Вклады

Наши вклады включают:

- Создание MedRGB: Мы устанавливаем MedRGB с четырьмя тестовыми сценариями для оценки LLM для медицинских задач QA в настройках RAG. По нашим данным, это первый бенчмарк, который комплексно оценивает медицинские системы RAG в этих практических условиях.

- Оценка LLM: Используя MedRGB, мы обширно оцениваем 7 LLM, включая как передовые коммерческие LLM, так и модели с открытым исходным кодом, в различных условиях RAG. Результаты экспериментов демонстрируют их ограничения в решении более сложных сценариев.

- Анализ ошибок и рассуждений: Мы анализируем ошибки LLM и их процесс рассуждений, чтобы предоставить ценные инсайты и предложить направления для дальнейшего развития более надежных и достоверных медицинских систем RAG.

Заключение

Эта статья расширяет оценку крупных языковых моделей (LLM) в настройках RAG для задач медицинского вопроса и ответа (QA), включая важные аспекты надежных медицинских систем AI, такие как достаточность, интеграция и устойчивость. Мы создаем Медицинский бенчмарк RAG (MedRGB), который предоставляет темы для поиска, релевантные документы, пары вопрос-ответ и противоречивые документы для четырех медицинских датасетов QA. Используя MedRGB, мы оцениваем широкий спектр LLM, включая как закрытые коммерческие, так и модели с открытым исходным кодом, и анализируем их процесс рассуждений в каждом из тестовых сценариев. Наши экспериментальные результаты раскрывают текущие ограничения систем RAG в обработке этих практических, но сложных ситуаций. Наши выводы предоставляют практические рекомендации и направления для дальнейшего развития более надежных и достоверных медицинских систем RAG.